대화형 인공지능 에이전트와 공감적 소통을 위한 눈 형태 UI 디자인 제안: 기쁨의 감정을 중심으로

초록

연구배경 대화형 인공지능 에이전트의 역할이 정서적 측면까지 확대됨에 따라 대인 간의 정서적 교감에서 비언어적 표현이 중요한 영향을 미치듯, 사용자에게도 공감의 신호를 시각적으로 제공해 보다 자연스럽고 친밀한 정서적 상호작용을 유도할 필요가 있다. 따라서 본 연구의 목적은 기쁨의 감정 대화에서 대화형 인공지능 에이전트가 사용자에게 자연스럽게 공감을 전달하는 눈 형태 UI 디자인을 제안하는 것이다.

연구방법 연구 방법은 선행 연구 고찰과 예비 연구 진행을 통해 기쁨의 감정을 약한 기쁨, 중간 기쁨, 강한 기쁨 등 세 가지 강도로 정의하고, 감정 표현의 매개체로서 사람의 눈에 집중해 각 강도에 따른 눈의 형태와 움직임을 분석하였다. 이를 기반으로 기쁨의 감정을 전달하는 눈 형태 UI 디자인을 제안하고, 실험을 통해 해당 디자인의 적용 여부가 사용자의 공감도(인지적 공감, 정서적 공감, 태도적 공감)에 미치는 영향을 검증하였다.

연구결과 연구 결과, 대화형 인공지능 에이전트에 대한 사용자의 공감도(인지적 공감, 정서적 공감, 태도적 공감)에 눈 형태 UI 디자인이 유의미한 영향을 미치며, 특히 사용자의 이야기를 적극적으로 경청하는 태도적 공감 요인을 크게 증진시키는 것을 확인할 수 있었다.

결론 본 연구의 결과를 바탕으로 기쁨의 감정 대화에서 대화형 인공지능 에이전트에 대한 사용자의 공감도를 증진시키기 위해서는 언어적 피드백뿐만 아니라 눈 형태 UI 디자인을 통한 시각적 피드백을 제공하는 것이 효과적임을 검증하였다.

Abstract

Background As the role of conversational artificial intelligence(AI) agents expands to encompass emotional aspects, akin to the significance of nonverbal cues in interpersonal emotional exchanges, there arises a critical necessity to integrate visual cues of empathy within user interactions. Therefore, this study aims to propose an eye-shaped user interface(UI) design for AI agents to naturally convey empathy to users during joyful emotional conversations.

Methods Through a review of previous studies and preliminary investigations, joy was defined in three intensities: mild joy, moderate joy, and strong joy. The study focused on human eyes as a medium of emotional expression, analyzing the forms and movements of eyes corresponding to each intensity. Based on this analysis, eye-shaped UI designs for conveying joy were proposed, and experiments were conducted to verify the impact of applying these designs on user empathy (cognitive empathy, affective empathy, attitudinal empathy).

Results Eye-shaped UI design significantly influenced user empathy (cognitive empathy, affective empathy, attitudinal empathy) towards conversational AI agents, particularly enhancing attitudinal empathy, characterized by actively listening to the user’s story.

Conclusions Providing visual feedback through eye-shaped UI design effectively enhances user empathy towards conversational AI agents in joyful emotional conversations.

Keywords:

Artificial Intelligence, Empathy, Emotional Communication, User Interaction, 인공지능, 공감, 감정 표현, 인터랙션 디자인1. 서론

1. 1. 연구의 배경 및 목적

대화형 인공지능 에이전트가 정보 검색이나 업무 보조 등의 비서 역할을 넘어 사용자와 감정을 나누는 정서적 상호작용의 대상으로 진화하고 있다. 이에 사용자와 자연스럽고 친밀한 감정적 교류를 유도하기 위해 단순히 감정을 표현하는 것을 넘어 사용자의 이야기에 공감하는 인공지능을 개발하기 위한 다양한 연구들이 진행되고 있다. 관련 연구들은 주로 음성 사용자 인터페이스(VUI: Voice User Interface)를 기반으로 음성 언어를 통한 공감 반응을 설계하는 것에 집중되어 있으며 상대적으로 시각적 표현을 통해 공감을 전달하려는 시도는 부족하다. 하지만, 대인 간의 정서적 교감에서도 시선이나 표정 등의 비언어적 표현이 중요한 영향을 미치듯 사용자와의 상호작용에서도 이러한 비언어적 형태의 공감 신호가 제공될 필요가 있다.

시인 허버트(Herbert, 1861)는 ‘눈은 온 세상에서 통용되는 유일한 언어’라고 말했다. 눈은 인간의 관심이나 행위에 관한 인지적 정보뿐만 아니라 정서적 측면도 나타낼 수 있는 중요한 신체 기관으로, 인간은 언어를 사용하지 않고도 서로의 눈을 통해 감정을 전달할 수 있다. 이와 같이 인간은 눈을 통해 상대의 정서를 이해하고 공감할 수 있으며, 이는 주로 상대의 얼굴 표정이나 움직임을 자동적으로 모방함으로써 나타난다. 따라서 본 연구는 감정 표현의 매개체로서 인간의 눈에 집중해 그 반응을 동일하게 모방함으로써 사용자와 공감적 소통을 이끌어내고자 한다.

인간의 눈은 다양한 감정을 표현할 수 있는데, 이와 관련해 스리니바산과 마르티네즈(Srinivasan & Martinez, 2021)는 북미, 남미, 유럽, 아시아, 호주 등 다섯 개 언어권에서 동일한 감정을 전달할 수 있는 보편적(Universal) 표정은 총 35개이며, 이 중 절반에 가까운 17개의 표정이 기쁨과 관련된 것을 확인하였다. 이에 대해 마르티네즈는 기쁨은 사회적 접착제 역할을 하며 다양한 얼굴 표정의 복잡성을 필요로 한다고 언급하였다. 따라서, 본 연구는 기쁨의 감정에 집중해 대화형 인공지능 에이전트가 사용자에게 자연스럽게 공감을 전달하는 눈 형태 사용자 인터페이스(UI: User Interface) 디자인을 제안하는 것을 목적으로 한다.

1. 2. 연구 범위 및 방법

본 연구의 목적을 달성하기 위해 첫째, 선행 연구 고찰과 예비 연구 진행을 통해 기쁨의 감정을 강도별로 정의하고, 각 강도에 따른 기쁨의 눈 형태 요소와 움직임 요소를 정의한다. 둘째, 앞서 정의된 형태 요소와 움직임 요소를 기반으로 기쁨의 강도별 눈 형태 UI 디자인을 제안하고 실험을 통해 의도된 기쁨의 감정을 유의하게 전달하는지 검증한다. 셋째, 제안된 눈 형태 UI 디자인 적용 여부에 따른 사용자의 공감도 차이를 실험을 통해 검증한다. 넷째, 실험 결과를 바탕으로 눈 형태 UI 디자인 적용 여부에 따른 사용자의 공감도 증진 효과에 대한 결론을 도출하고 향후 연구의 방향을 제시한다.

2. 눈의 감정 표현 연구 고찰

2. 1. 기쁨

기쁨이란 욕구가 충족되었을 때 발생하는 긍정적 감정으로 흐뭇하고 흡족한 마음이나 느낌을 의미한다. 기쁨은 강도에 따라 여러 단계로 구분되는데, 이와 관련해 러셀(Russell, 1980)은 높은 강도의 기쁨은 흥분된 상태와 연관되고 낮은 강도의 기쁨은 이완된 상태와 연관되는 것으로 정의하였다. 또한, 플루치크(Plutchik, 1991)는 기쁨을 강도에 따라 평온함(Serenity), 즐거움(Joy), 황홀함(Ecstasy)으로 구분하였으며, 맥클라우드(McCloud, 2006)는 얼굴 표정 강도에 따라 만족(Satisfaction), 즐김(Amusement), 기쁨(Joy), 폭소(Laughter) 등 네 가지로 구분하였다. 이어 황민지, 한지애, 김병욱(Hwang, Han & Kim, 2021)은 기쁨의 감성 어휘를 세 가지 강도로 분류했다. 이를 바탕으로 기쁨의 강도를 약, 중, 강 세 단계로 구분해 Table 1과 같이 정의하였다.

2. 2. 공감

공감이란 타인의 눈을 통해 세상을 바라보며 정서 상태와 경험을 공유하고 이해하는 것을 말한다. 데이비스(Davis, 1983)는 공감이 상대방의 입장을 이해하는 인지적 능력뿐만 아니라 상대방과 유사한 감정을 경험하는 것과 그에 대한 정서적 반응까지 포괄한다고 정의하였다. 이와 관련해 해트필드(Hatfield, 2009)는 사람들이 상대방의 얼굴 표정을 자동적으로 모방함으로써 안면 근육을 움직이게 되고, 이러한 근육의 움직임이 뇌로 전달되어 정서적 경험을 야기한다고 주장하였다. 오예전, 신윤수, 이지항, 김진우(Oh, Shin, Lee & Kim, 2017) 또한 컴패니언 로봇의 얼굴 표정 따라하기 피드백이 상황에 대한 몰입을 도와 모방 대상자의 공감을 높이는 데 효과적임을 확인하였다.

공감을 측정하는 도구로는 데이비스(Davis, 1980)가 개발한 대인관계반응지수(IRI: Interpersonal Reactivity Index)와 배런 코언과 휠라이트(Baron-Cohen & Wheelwright, 2004)가 개발한 공감지수(EQ: Empathy Quotient)가 주로 사용되고 있다. 해당 척도들은 공감의 개념을 단일 차원이 아닌 복합적인 개념으로 보고 인지적, 정서적 차원을 모두 측정할 수 있도록 설계되었다. 김윤희와 김진숙(Kim & Kim, 2017)은 이러한 선행 연구들을 기반으로 한국의 문화적 맥락을 반영한 공감 척도를 제안하며, 인지적, 정서적 요인에 태도적 요인을 추가하였다. 이를 바탕으로 본 연구는 공감의 구성 요인을 Table 2와 같이 정의하였다.

2. 3. 눈을 통한 감정 표현

감정 표현의 매개체로서 눈에 집중한 연구들은 주로 소셜 로봇이나 애니메이션 관련 연구에 집중되어 있다. Table 3은 선행 연구에서 정의된 눈의 감정 표현 요소를 정리한 것으로, 임윤아, 이은아, 권지은(Lim, Lee & Kwon, 2017)은 디지털 콘텐츠상에서 감성을 구분할 수 있는 눈의 요소를 눈매, 시선, 홍채 크기, 특수 효과 등 네 가지로 정의하였다. 또한, 이슬비와 유승헌(Lee & Yoo, 2017)은 실버 세대를 위한 컴패니언 로봇 디자인에서 눈썹 근육과 눈꺼풀, 광대, 동공 크기 등을 그래픽으로 표현해 정보 맥락에 일치하는 감정을 표현하고자 하였다. 이어 박다솜과 반영환(Park & Ban, 2019)은 소셜 로봇과의 감정 커뮤니케이션에서 눈동자와 눈꺼풀의 움직임을 통한 감정 교류가 효과적임을 확인하였으며, 황민지, 한지애, 김병욱(Hwang, Han & Kim, 2021)은 반응형 캐릭터의 감정 표현을 위한 주요 코딩 파라미터를 눈, 눈동자, 눈꺼풀, 입으로 도출해 표정 코딩 시스템을 제안하였다.

이와 같이 눈을 통한 감정 표현 연구는 주로 얼굴 표정의 일부로서 눈을 다루며, 이를 매우 실재적이고 직접적으로 표현하려는 시도가 많았다. 하지만 퐁, 누르바흐쉬, 다우텐한(Fong, Nourbakhsh & Dautenhahn, 2003)은 실재적 형태가 아닌 추상적 형태를 통해서도 소셜 로봇과 충분히 감정을 교류할 수 있음을 증명하였다. 강보윤과 전수진(Kang & Jun, 2022) 또한 추상적 형태의 그래픽 인터랙션을 통해 소셜 로봇과 사용자 간의 효과적인 감정 커뮤니케이션이 가능하다는 점을 확인하였다. 따라서, 본 연구에서는 사람의 눈을 실재적으로 묘사하기보다 추상적 형태로 표현해 보다 다양하고 유연하게 기쁨의 감정을 전달하고자 한다.

3. 눈을 통한 기쁨의 표현

3. 1. 기쁨의 눈 형태 예비 연구

눈의 감정 표현 요소를 추출하고 이를 기반으로 기쁨의 강도별 눈 형태를 정의하기 위해 디자인 전공자 여섯 명(남성 1명, 여성 5명)을 대상으로 예비 연구를 실시하였다. 참여자들은 기쁨의 강도별로 떠오르는 감성 어휘와 상황을 각각 작성하고, 이에 대한 눈 형태를 묘사하였다. 그 결과, 총 60개의 기쁨의 감성 어휘가 수집되었으며, 각 강도별로 공통적으로 언급된 감성 어휘를 아래 Table 4와 같이 정리하였다.

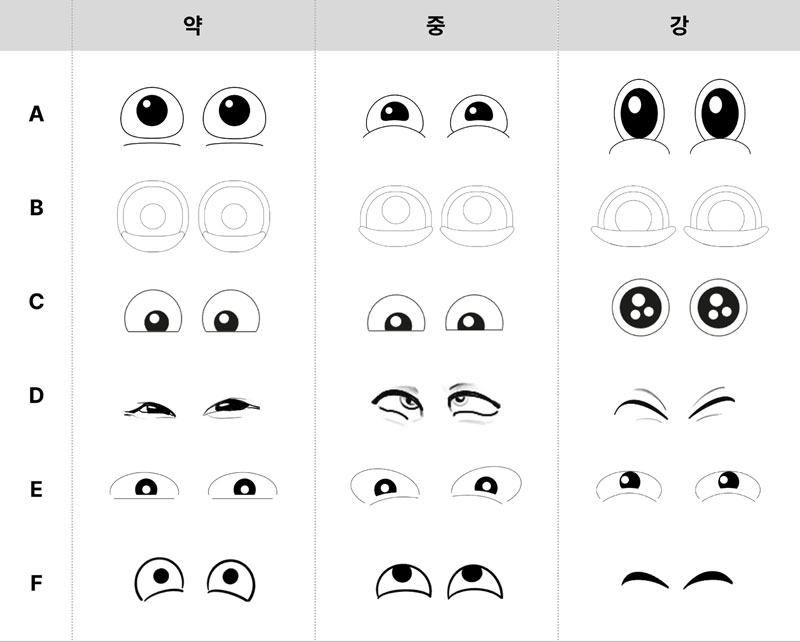

기쁨의 강도별 눈 형태는 참여자에 따라 묘사 방식에 차이가 있었으나, 공통적으로 애니메이션 캐릭터나 이모티콘과 같이 눈의 특정 요소를 강조해 강도의 차이를 표현한 것으로 나타났다. 기쁨의 강도가 강해질수록 눈의 모양을 확대 혹은 축소하여 표현하였는데, 확대된 눈의 경우 기쁨과 놀라움의 감정이 복합적으로 묘사된 것으로 확인하였다. 또한, 기쁨의 강도가 강해질수록 눈동자와 아래 눈꺼풀의 위치가 높게 상승하는 모습을 보였는데, 특히 강한 기쁨에서는 아래 눈꺼풀이 매우 높게 상승해 눈의 전체적인 모양이 크게 축소되는 것을 확인하였다. 이를 바탕으로 기쁨의 감정을 표현하는 눈의 형태 요소를 눈 모양, 눈동자 위치, 아래 눈꺼풀 위치 등 세 가지로 추출하였다. 해당 요소들의 강도별 변화는 Table 5와 같이 정리하였다. 참여자별로 묘사한 기쁨의 눈 형태는 Figure 1과 같다.

3. 2. 기쁨의 움직임

대화형 인공지능 에이전트가 사용자에게 효과적으로 기쁨의 감정을 전달하기 위해서는 눈의 형태적 변화와 더불어 몸의 움직임을 통한 감정 표현 요소를 살펴볼 필요가 있다. 이를 위해 본 연구에서는 라반과 울먼(Laban & Ullmann, 1971)의 라반 움직임 분석(LMA: Laban Movement Analysis)에 따른 질적 요소를 살펴보았다. 라반은 인간이 움직임을 행할 때 동기나 마음가짐이 움직임의 구조적 특질을 만들어낸다고 보고 이를 에포트(Effort)라고 정의하였다. 에포트는 흐름(Flow), 무게(Weight), 시간(Time), 공간(Space) 등 네 가지 인자로 구성되는데, 흐름은 움직임의 자유도에 따라 자유로운 흐름과 통제되는 흐름으로 구분되며, 무게는 중력과 연관되어 가벼운 무게와 강한 무게로 구분된다. 시간은 움직임의 완성 과정과 관련되어 빨라지는 시간과 느려지는 시간으로 구분되며, 공간은 목표지점에 집중해 움직이는 직접적 공간과 산만하게 움직이는 간접적 공간으로 구분된다. 이와 관련해 강주선(Kang, 2018)은 LMA를 기반으로 베스(BESS) 감정 모형을 개발하였는데, 해당 모형에서 기쁨의 동작을 희망, 신나고 즐거움, 흥분과 황홀 등으로 세분화해 정리하였다. 또한 김미숙(Kim, 2015)은 기쁨의 몸짓을 두 가지로 구분해 편안한 기쁨은 몸에 힘이 들어가지 않고 이완된 상태의 접촉으로, 격정적 기쁨은 주먹을 하늘로 뻗는 듯한 힘 있는 몸짓으로 정의하였다. 이러한 선행 연구들을 바탕으로 각 강도별 감성 어휘에 따른 기쁨의 움직임을 Table 6과 같이 정의하였다.

3. 3. 공감의 대화

인공지능은 자연어 처리 기술을 통해 텍스트에 담긴 감정의 유형을 이해하고 분류하도록 훈련된다. 이를 위해서는 구체적인 대화 상황을 설정하는 것이 중요한데, 문장에 뚜렷한 상황이나 감정 용언이 드러날 경우 인공지능이 더욱 쉽고 명확하게 감정을 인식할 수 있기 때문이다. 따라서, 본 연구에서는 예비 연구를 통해 각 강도별 기쁨의 상황을 정의하였다. 그 결과, 약한 기쁨은 맛있는 음식을 즐기거나 좋아하는 노래를 듣는 등 일상에서 오는 만족스럽고 평온한 상황에서 느끼는 것으로 나타났으며, 중간 기쁨은 가족들과의 휴가나 친구들과의 모임 등 타인과 상호작용에서 경험하는 즐거운 상황에서 느끼는 것으로 나타났다. 이어 강한 기쁨은 대학 입학이나 취업, 결혼 등 특별한 성취나 중요한 삶의 사건과 관련된 상황에서 느끼는 것으로 확인하였다. 이를 기반으로 Table 7과 같이 대화형 인공지능 에이전트와 사용자 간의 기쁨의 공감 대화를 제안하였다. 각 대화는 인공지능이 기쁨의 강도를 명확히 구분할 수 있도록 구체적인 상황과 감정 용언을 제시하였으며, 사용자의 감정을 동일하게 모방해 공감 반응을 전달하도록 설계되었다.

4. 공감적 소통을 위한 UI 디자인 제안

4. 1. 눈 형태 UI 디자인 제안

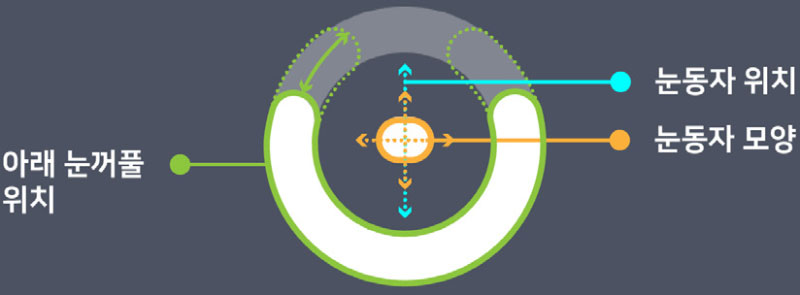

앞서 정의된 형태 요소와 움직임 요소를 기반으로 기쁨의 감정을 표현하는 눈 형태 UI 디자인의 구조를 Figure 2와 같이 제안하였다. 해당 UI 디자인은 사람의 눈을 실재적으로 묘사하지 않고, 다양한 대화형 인공지능 에이전트의 화면 피드백에 확정적으로 적용할 수 있도록 추상적 형태로 표현되었다. 눈동자와 아래 눈꺼풀은 각각 중심의 원과 바깥의 원으로 표현되었는데, 눈동자의 변화는 매우 미세하기 때문에 제한된 화면 안에서 효과적인 감정 전달을 위해 눈과 눈동자의 움직임을 통합해 눈동자로 정의하고 중심의 원으로 표현하였다.

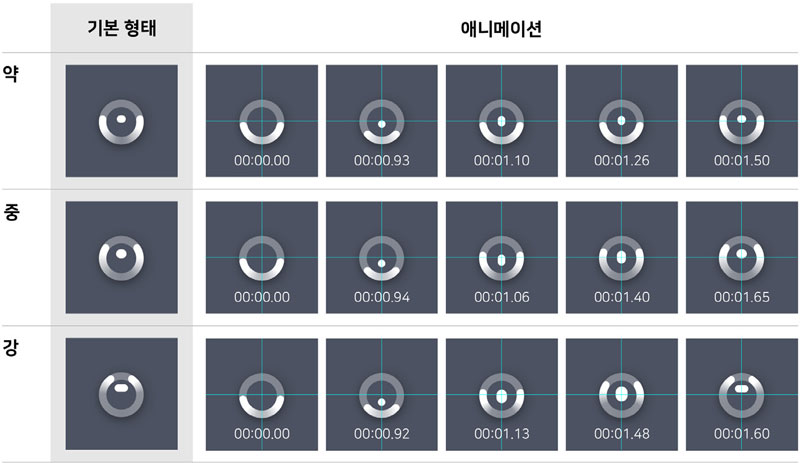

이를 기반으로 각 기쁨의 강도별 눈 형태 UI 디자인을 Figure 3과 같이 제안하였다. 눈동자를 표현한 중심의 원은 대화 시작과 동시에 화면 하단에서 등장해 사용자와의 눈 맞춤을 통해 대화형 인공지능 에이전트가 적극적으로 대화에 참여할 준비가 되었음을 시각적으로 인지하게 한다. 이 중심의 원은 기쁨의 강도에 따라 상하 혹은 좌우로 확장되며 감정을 극대화하도록 설계되었으며, 실제 눈은 뛰어오르는 듯한 움직임을 보일 수 없지만 효과적인 감정 전달을 위해 몸의 움직임 요소를 통합해 표현하였다. 바깥 원으로 표현된 아래 눈꺼풀 또한 눈꺼풀이 상승하면서 눈의 모양이 좁게 변하는 실재적 묘사를 따르지 않고, 감정의 강도 상승에 따라 게이지가 차오르는 듯한 은유적 표현을 채택하였다. 더불어 실제 아래 눈꺼풀은 양쪽으로 갈라지거나 좌우로 흔들릴 수 없지만 강한 기쁨의 감정을 강조하기 위해 하늘로 주먹을 뻗는 듯한 몸의 움직임을 강조해 표현하였다. 해당 UI 디자인은 형태와 움직임의 변화에 초점을 맞추기 위해 색상을 제외하고 표현되었다.

4. 2. 눈 형태 UI 디자인 검증

해당 UI 디자인이 사용자에게 의도된 기쁨의 감정을 유의하게 전달하는지 검증하기 위해 22명(남성 8명, 여성 14명)의 성인을 대상으로 실험을 진행하였다. 피험자들은 온라인 설문을 통해 각 강도별 영상 실험 자극물을 시청한 후, 해당 영상에서 느낀 감정의 종류를 선택하고 이어 가장 강하게 느낀 감성 어휘를 선택하였다. 수집된 자료는 IBM SPSS Statistics 29.0 프로그램을 통해 교차 분석을 실시하였다. 분석 결과, 세 가지 영상에서 모두 기쁨의 감정을 느끼는 것으로 나타났으며, 기쁨의 강도별 영상과 감성 어휘에 대한 교차 분석 결과 Table 8과 같이 p<0.001로 나타나 통계적으로 유의한 것으로 나타났다. 따라서, 세 가지 영상 실험 자극물과 피험자가 선택한 감성 어휘에는 유의미한 연관성이 있으며, 이는 각 강도별 눈 형태 UI 디자인이 피험자에게 의도한 기쁨을 전달했음을 의미한다.

5. 눈 형태 UI 디자인 공감도 실험 설계

5. 1. 연구 문제

본 연구는 기쁨의 감정 대화에서 대화형 인공지능 에이전트가 사용자에게 자연스럽게 공감을 전달하는 눈 형태 UI 디자인을 제안하는 것을 목적으로 하기에 다음과 같은 연구 문제를 제안한다.

눈 형태 UI 디자인은 대화형 인공지능 에이전트에 대한 사용자의 공감도(인지적 공감, 정서적 공감, 태도적 공감)를 증진시킬 수 있는가?

5. 2. 실험 자극물

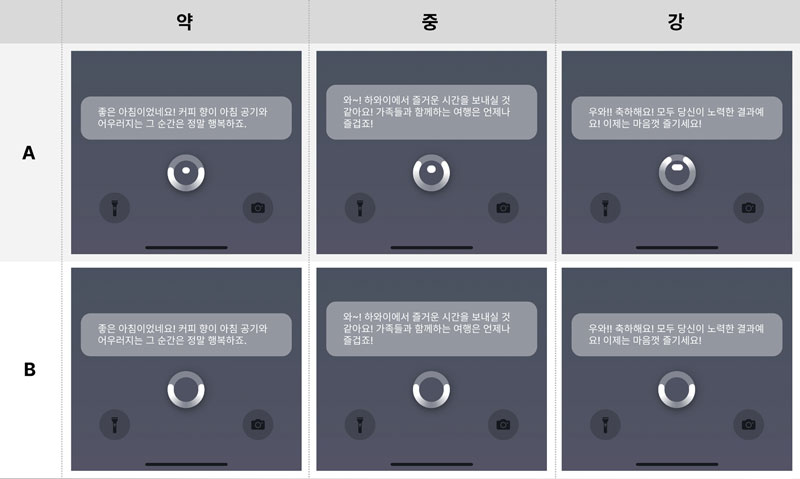

앞서 제안된 기쁨의 강도별 눈 형태 UI 디자인과 기쁨의 공감 대화를 바탕으로 영상 실험 자극물을 제작하였다. 눈 형태 UI 디자인 적용 집단(A)과 눈 형태 UI 디자인 미적용 집단(B)으로 구분되어 총 여섯 개의 영상 실험 자극물이 제작되었다. B집단의 영상은 눈동자의 형태적 요소가 제외되어 있으며, 시장에 출시된 기존의 대화형 인공지능 에이전트의 UI와 유사하게 모든 강도에서 동일한 속도와 형태로 움직이도록 설계되었다. 본 연구에서는 눈 형태 UI 디자인 적용 여부에 따른 시각적 피드백의 공감도 증진 효과를 확인하고자 하기에 언어적 피드백은 모두 동일하게 적용되었다. 각 집단에 따른 기쁨의 강도별 영상 실험 자극물을 Figure 4와 같다.

5. 3. 연구 방법 및 설문 설계

전체 연구 과정은 온라인으로 진행되었으며, 영상 시나리오 방법을 채택하였다. 피험자들은 눈 형태 UI 디자인 적용 집단과 눈 형태 UI 디자인 미적용 집단 총 두 집단으로 무작위로 배정되었으며, 영상 실험 자극물을 시청 후 온라인 설문을 통해 대화형 인공지능 에이전트에 대한 인지적, 정서적, 태도적 공감도를 측정하는 문항에 응답하였다. 이를 위해 HAI(Human-AI Interaction) 공감 척도(Cho, 2024)를 5점 척도로 구성해 사용하였으며, 피험자에게 제공된 설문 문항은 Table 9와 같다. 더불어, 질적인 답변을 수집하기 위해 각 집단마다 세 명의 피험자를 선정해 총 여섯 명에 대한 심층 인터뷰를 진행하였다.

6. 눈 형태 UI 디자인 공감도 실험 결과

6. 1. 연구 대상

결과 분석에는 대화형 인공지능 에이전트를 1회 이상 사용한 경험이 있는 성인 총 89명(남성 43명, 여성 46명)의 데이터가 사용되었다. 연령의 분포는 20대(35%), 30대(55%), 40대(7%), 50대 이상(3%)으로 구성되었다. 눈 형태 UI 적용 집단(44명; 남성 20명, 여성 24명), 눈 형태 UI 미적용 집단(45명; 남성 23명, 여성 22명) 총 두 집단에게 설문이 배정되었다. 수집된 자료는 IBM SPSS Statistics 29.0 프로그램을 통해 독립표본 t-검정을 실시하였다.

6. 2. 공감도 실험 결과

눈 형태 UI 디자인 적용 여부에 따른 공감도 차이 검정 결과, Table 10과 같이 모든 강도의 기쁨에서 눈 형태 UI 디자인 미적용 집단(B)보다 눈 형태 UI 디자인 적용 집단(A)의 공감도가 유의미하게 높게 나타났다. 약한 기쁨의 경우, A집단(M=3.74, SD=0.69)의 공감도가 B집단(M=3.32, SD=0.75)보다 높게 나타났으며, 중간 기쁨의 경우도 A집단(M=3.93, SD=0.62)의 공감도가 B집단(M=3.36, SD=0.63) 보다 높은 것으로 확인되었다. 강한 기쁨에서도 A집단(M=4.20, SD=0.65)의 공감도가 B집단(M=3.28, SD=0.56)의 공감도 보다 유의미하게 높았다. 따라서, 본 연구에서 제안된 눈 형태 UI 디자인은 사용자의 공감도 증진에 유의미한 영향을 미치는 것으로 나타났다. 더불어, 모든 공감 요인의 하위 문항들 간 응답의 신뢰도는 0.60 이상으로 나타났다.

각 강도별로 공감 요인을 살펴보면 Table 11과 같이 약한 기쁨에서는 눈 형태 UI 디자인 적용 여부에 따라 정서적 공감 요인과 태도적 공감 요인에서는 유의미한 차이가 나타났으나, 인지적 공감 요인에서는 유의미한 차이를 발견하지 못했다. 중간 기쁨의 경우, 모든 공감 요인에서 눈 형태 UI 디자인 적용 여부에 따른 유의미한 차이가 나타났으며 특히 태도적 공감 요인의 평균이 유의하게 높아진 것을 확인하였다. 이어 강한 기쁨의 경우, 모든 공감 요인에서 유의미한 차이를 확인하였으며 중간 기쁨과 동일하게 태도적 공감 요인에서 큰 차이를 확인하였다.

7. 결론 및 제언

본 연구는 기쁨의 감정을 추상적으로 표현하는 눈 형태 UI 디자인을 통해 대화형 인공지능 에이전트에 대한 사용자의 공감도를 증진시킬 수 있는 새로운 공감 인터랙션 방식을 제시하는 것을 목적으로 하였다. 따라서, 본 연구에서 제안한 눈 형태 UI 디자인은 사용자의 공감도 증진에 유의미한 영향을 미친다는 것을 확인하였다. 특히, 모든 강도의 기쁨에서 사용자의 이야기를 적극적으로 경청하는 태도적 공감 요인이 크게 상승한 것을 확인하였다. 이를 바탕으로 대화형 인공지능 에이전트에 대한 사용자의 공감을 높이기 위해서는 언어적 피드백뿐만 아니라, 사용자의 감정을 적극적으로 모방한 시각적 피드백이 함께 제공되는 것이 더욱 효과적이며 이를 통해 보다 활발한 정서적 상호작용을 유도할 수 있다는 가능성을 확인하였다.

다만, 약한 기쁨의 인지적 공감 요인에서 유의미한 차이가 나타나지 않았는데 이에 대해 심층 인터뷰를 통해 질적인 답변을 수집한 결과, 상대적으로 소극적인 움직임으로 표현되는 약한 기쁨의 공감 반응은 작은 모바일 화면에서는 그 변화를 명확히 인지하기 어려운 것으로 나타났다. 따라서, 약한 기쁨의 인지적 공감 요인을 높이기 위해서는 보다 명확히 감정을 전달할 수 있는 디자인 개발과 더불어 UI가 적용되는 화면의 크기를 고려할 필요가 있으며, 작은 화면에서는 보다 강하고 과장된 움직임으로 감정을 표현할 필요가 있다. Figure 5는 이러한 연구의 결과를 반영해 인지적 공감 요인을 개선한 UI를 제안한 것이다. 약한 기쁨에서 보다 분명히 공감의 반응을 전달할 수 있도록 중심 원의 크기와 형태를 조정하고, 속도 또한 느리게 조절해 발랄한 느낌을 줄이고 온화한 눈웃음을 연상할 수 있도록 하였다. 또한, 중간 기쁨과 강한 기쁨에서도 인지적 공감 요인을 상승시킬 수 있도록 중심 원의 크기와 바깥 원의 그러데이션을 보다 강하게 조정하였다.

본 연구에서는 기쁨이라는 긍정적 감정 한 가지를 집중해 다루었으나 향후 연구에서는 다양한 사용자의 감정에 대응할 수 있는 공감적 UI로의 발전이 필요하다. 슬픔이나 분노 같은 부정적 감정뿐만 아니라 호기심이나 절박함, 홀가분함 등 복합적인 감정에 대해서도 확장적으로 연구를 진행할 필요가 있다. 추가적으로, 본 연구는 한국인을 대상으로 기쁨의 강도별 상황이나 눈 형태를 수집하고 정의하였기 때문에 다른 문화권에서의 적용이 어려울 수 있다. 특히 표정은 문화에 따라 범주화되는 방식이 상이하기 때문에 본 연구에서 제시된 상황을 동일하게 인식하더라도 다른 감정이나 표정으로 묘사할 수 있다는 점을 고려해야 한다. 또한, 본 연구의 UI 디자인은 모바일 기기로의 적용을 가정해 디자인되었기 때문에 해당 UI 디자인이 태블릿 PC나 노트북 등 다른 크기의 화면에 적용되었을 때 느껴지는 인상과 감성을 비교하는 연구도 의미가 있을 것이다.

Acknowledgments

This paper was written based on the Master’s Thesis of Seoul National University in 2024.

이 논문은 2023년 대한민국 교육부와 한국연구재단의 공동연구지원사업의 지원을 받아 수행된 연구임(NRF-2023S1A5A2A03084950)

This work was supported by the Ministry of Education of the Republic of Korea and the National Research Foundation of Korea(NRF-2023S1A5A2A03084950)

The video stimuli used in this paper were created by the author. To access the video, please refer to the following link:

Cho, Y. [StimuliHub]. (2023, Nov 2). Video Stimulus: A [Video]. YouTube. Retrieved from: https://youtu.be/SL7fxf1FFQE

Cho, Y. [StimuliHub]. (2023, Nov 2). Video Stimulus: B [Video]. YouTube. Retrieved from: https://youtu.be/fGg3zZbHsxI

Cho, Y. [StimuliHub]. (2023, Nov 2). Video Stimulus: C [Video]. YouTube. Retrieved from: https://youtu.be/Kw-wO_Nc3fg

Notes

Copyright : This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0/), which permits unrestricted educational and non-commercial use, provided the original work is properly cited.

References

-

Baron-Cohen, S., & Wheelwright, S. (2004). The empathy quotient: an investigation of adults with Asperger syndrome or high functioning autism, and normal sex differences. Journal of autism and developmental disorders, 34, 163-175.

[https://doi.org/10.1023/B:JADD.0000022607.19833.00]

- Cho, Y. (2024). 대화형 AI 에이전트와 공감적 소통을 위한 눈 형태 UI 디자인 제안: 기쁨의 감정을 중심으로 [A Proposal for Eye-shaped UI Design for Empathy with AI Agents: Focusing on the Emotion of Joy] (Unpublished master's thesis). Seoul National University, Seoul, Korea.

- Davis, M. (1980). A Multidimensional Approach to Individual Differences in Empathy. JSAS Catalog of Selected Documents in Psychology, 10, 85.

-

Davis, M. (1983). Measuring individual differences in empathy: Evidence for a multidimensional approach. Journal of Personality and Social Psychology, 44(1), 113-126.

[https://doi.org/10.1037/0022-3514.44.1.113]

-

Fong, T., Nourbakhsh, I., & Dautenhahn, K. (2003). A survey of socially interactive robots. Robotics and autonomous systems, 42(3-4), 143-166.

[https://doi.org/10.1016/S0921-8890(02)00372-X]

-

Hatfield, E., Cacioppo, J. T., & Rapson, R. L. (1993). Emotional contagion. Current directions in psychological science, 2(3), 96-100.

[https://doi.org/10.1111/1467-8721.ep10770953]

- Herbert, G. (1861). The Poetical Works of George Herbert and Reginald Heber. Edinburgh: Gall & Inglis.

-

Hwang, M., Han, J., & Kim, B. (2021). 반응형 캐릭터의 표정 코딩을 위한 감정 맵 제안 [A Proposal of Emotion Map for Facial Coding on Reactive Character]. Journal of Industrial Design Studies, 15(2), 65-73.

[https://doi.org/10.37254/ids.2021.06.56.06.65]

-

Kang, B., & Jun, S. (2022). 소셜 로봇의 감정 표현과 의인화 형태에 대한 사용자 인식 연구 한국디자인학 연구 동향에 대한 분석 [User Perception of Social Robot's Emotional Expression and Forms of Anthropomorphism]. Archives of Design Research, 35(2), 137-153.

[https://doi.org/10.15187/adr.2022.05.35.2.137]

-

Kang, J. (2018). 라반의 움직임이론을 이용한 K 팝 댄스 감정모형 개발 연구 [A Study on the Development of K-pop Dance Emotion Model Using Laban's BESS Movement Theory]. Journal of the Korea Entertainment Industry Association, 12(3), 249-266.

[https://doi.org/10.21184/jkeia.2018.4.12.3.249]

- Kim, M. (2015). 애니메이션 속 캐릭터의 감정에 따른 표정과 몸짓 연구Ⅰ [A Study on the Facial Expressions and the Gestures of Emotion for the Character Animation I]. The Korean Journal of Animation, 11(4), 23-42.

-

Kim, Y., & Kim, J. (2017). 공감 척도 개발 및 타당화 [Development and Validation of Empathy Scale]. Korea Journal of Counseling, 18(5), 61-84.

[https://doi.org/10.15703/kjc.18.5.201710.61]

- Laban, R., & Ullmann, L. (1971). The mastery of movement (Revised 3rd ed. by Ullman, L). Boston: Plays.

- Lee, S., & Yoo, S. (2017). 컴패니언 로봇의 멀티 모달 대화 인터랙션에서의 감정 표현 디자인 연구 [Design of the emotion expression in multimodal conversation interaction of companion robot]. Design Convergence Study, 16(6), 137-152.

- Lim, Y., Lee, E., & Kwon, J. (2017). 감성 커뮤니케이션을 위한 디지털 눈 콘텐츠 표현 연구 [A Study on The Expression of Digital Eye Contents for Emotional Communication]. Journal of Digital Convergence, 15(12), 563-571.

- McCloud, S. (2006). Making comics: Storytelling secrets of comics, manga and graphic novels. New York: HarperCollins Publishers.

- Oh, Y., Shin, Y., Lee, J., & Kim, J. (2017). 감정 상태에 따른 컴패니언 로봇의 인터랙션 디자인 [A Study on Interaction Design of Companion Robots Based on Emotional State]. Journal of Digital Contents Society, 18(7), 1293-1301.

- Park, D., & Ban, Y. (2019). 소셜 로봇의 눈동자 움직임을 통한 인간-로봇의 감정 커뮤니케이션에 관한 연구 [A Study on Human-Robot's Emotional Communication through the Movement of the Eye of a Social Robot]. Journal of Korea Design Forum, 24(2), 129-138.

-

Russell, J. A. (1980). A circumplex model of affect. Journal of personality and social psychology, 39(6), 1161.

[https://doi.org/10.1037/h0077714]

-

Srinivasan, R., & Martinez, A. (2021). Cross-Cultural and Cultural-Specific Production and Perception of Facial Expressions of Emotion in the Wild. IEEE Transactions on Affective Computing, 12(3), 707-721.

[https://doi.org/10.1109/TAFFC.2018.2887267]