텍스트 기반 커뮤니케이션에서 서체를 활용한 감정 표현 메신저가 사용자의 커뮤니케이션 상호작용에 미치는 영향

초록

연구배경 텍스트 기반 커뮤니케이션에서 텍스트가 가진 정적인 특성은 현재까지도 큰 변화 없이 이어져 오는 특성이다. 그중 메신저 서비스는 이모티콘과 같은 수단으로 감정 표현을 시도하고 있지만, 직접 얼굴을 마주하여 대화할 때만큼 사람마다 다른 감정을 담아 전달하는 것에는 한계가 나타났다. 본 연구는 서체와 사용자의 표정을 활용한 직접적이고 자연스러운 감정 표현을 가능하게 하는 메신저의 새로운 감정 표현을 심층적으로 알아보고자 하였다.

연구방법 텍스트 기반 커뮤니케이션에서 나타나는 감정 표현에 대한 이론적 고찰을 통해 Ekman(1999)이 제시한 인간의 보편적인 6대 감정을 선정하였다. 본 연구에서는 감정 표현 방법으로 서체를 활용하고자 50개의 한글 서체를 선정하여 각 서체에서 느껴지는 감정과 감정 요인을 설문조사로 확인하였다. 이를 다차원척도법 분석 을 통해 서체와 감정, 정서 단어의 높은 상관관계가 있는 30개 세트를 매칭시켜 메신저 프로토타입으로 제작하였다.

연구결과 대면 상황에서 감정 표현의 사용 빈도는 비언어적 표현이 높았고, 언어적 표현은 상대적으로 낮았다. 언어와 비언어적 표현의 불일치로 인한 커뮤니케이션의 오해가 발생하는 경우도 나타났다. 메신저에서는 텍스트의 정적인 특성을 완화하는 수단으로 이모티콘을 주로 사용하였고, 텍스트에서의 감정 파악에 한계를 느꼈다. 또한, 텍스트 기반의 정형화된 표현에 부정적이었으며, 이는 기존 메신저에 대한 한계점으로 나타났다. EmoChat에서의 감정 표현은 메신저에서의 새로운 감정 표현 방식이며, 기존의 감정 파악의 한계가 개선될 것이라 평가하였다. 또한, 대화의 맥락과 표현의 일치성과 대면 상황에 가까운 메신저의 감정 교류를 언급하였으며, 새로운 관계나 친밀도가 낮은 관계에서 유용할 것으로 나타났다.

결론 본 연구는 서체를 활용하여 감정 표현을 향상시키는 메신저 프로토타입 EmoChat을 개발하고 사용자 평가를 통해 텍스트 기반 커뮤니케이션의 한계를 개선한 것에 중점을 두었다. 메신저에서 사용자의 감정 표현을 다양화함으로써 대면 상황에서의 대화와 유사한 사용자 경험을 제공하였다. 이는 메신저 서비스에서의 새로운 사용자 경험을 제공하고 사용자 간 커뮤니케이션을 향상시키는 데 기여할 것으로 기대한다.

Abstract

Background The static nature of text in text-based communication has remained largely unchanged to this day, and while messenger services have tried to express emotions through means such as emoticons, they have shown limitations in conveying emotions that vary from person to person as much as in face-to-face conversations. In this study, we aim to explore in-depth new emotional expressions in messengers that enable direct and natural emotional expressions using typefaces and users’ facial expressions.

Methods Through a theoretical review of emotional expressions in text-based communication, the six universal human emotions proposed by Ekman(1999) were selected. In this study, 50 Korean typefaces were selected to utilize typefaces as a method to express emotions, and the emotions and emotion factors felt in each typeface were identified through a survey. Through multidimensional scaling analysis, 30 sets with high correlation between typefaces, emotions, and affective words were matched to create a messenger prototype.

Results In face-to-face situations, nonverbal expressions of emotion were used often and verbal expressions were used less often. The mismatch between verbal and nonverbal expressions also led to misunderstandings in communication. In messengers, users mainly used emoticonsto alleviate the static nature of text, and users felt the limitations of identifying emotions in text. They were also negative about text-based, structured expressions, which was a limitation of existing messengers. EmoChat is a new way of expressing emotions in messengers, and they evaluated that it wouldimprove the limitations of existing emotion identification. They also mentioned the congruence between the context of the conversation and the expression and the emotional exchange in the messenger that is close to the face-to-face situation, which is useful in new relationships or relationships with low intimacy.

Conclusions This study focuses on the development of EmoChat, a messenger prototype that utilizes typefaces to enhance emotional expression, and user evaluation to improve the limitations of text-based communication. By diversifying users’ emotional expressions in the messenger, we provide user experiences similar to conversations in face-to-face situations. This is expected to provide a new user experience in messenger services and to improve communication between users.

Keywords:

Emotion, Affect, Messenger, Typeface, Interface Design, User Experience키워드:

감정, 정서, 메신저, 서체, 인터페이스 디자인, 사용자 경험1. 서론

이메일에서 게시판, 인스턴트 메시징(instant messaging)에 이르기까지 텍스트 기반의 컴퓨터 매개 커뮤니케이션(computer-mediated communication)에서 텍스트가 가진 정적인(static) 특성은 오랜 전통에도 불구하고 현재까지도 큰 변화 없이 이어져 오는 특성이다. 컴퓨터나 스마트폰에서는 메신저(messenger) 서비스를 사용해 상대방과 대화를 나누고 정보를 교환할 수 있지만, 텍스트가 가진 특성의 한계로 인해 상대방과 직접 얼굴을 마주하여 대화할 때만큼 감정(emotion)을 담아 전달하는 것에는 무리가 있다. 하지만 컴퓨터의 도래 이후 꾸준히 전개되어 온 컴퓨터 매개 커뮤니케이션 발전 과정에서 텍스트가 구술성(orality)을 가지게 되면서 과거와는 달리 동시적인 커뮤니케이션의 도구로 진화하게 되었다(Ong, 2013). 이에 텍스트 기반 커뮤니케이션에서도 즉각적인 감정 전달의 필요성이 증가하였다.

현재 텍스트 기반의 커뮤니케이션에서 감정을 표현하기 위해 가장 활발히 사용되는 이모티콘(emoticon)이 좋은 예이다. 스콧 팔만(Scott Fahlman) 교수는 온라인 게시판에서 불필요한 감정의 충돌을 막기 위해 농담이나 기쁜 감정, 혹은 불쾌한 감정을 콜론 ‘:’과 괄호 기호를 조합한 ‘:-)’, ‘:-(’ 형태인 ‘스마일리(smiley)’를 통해 표현하자고 제안하였다. 이모티콘의 사용은 정보 전달뿐만 아니라 대화의 무게 조절을 위해 사용하기도 하며, 부드러운 의사소통을 유도하기도 한다(Kim, 2012; Derks et al., 2008). 이후 움직이는 그림이나 3D, AR 기술이 적용된 이모지(emoji) 등도 감정 표현을 보완하기 위해 사용되기 시작되었지만, 일반적으로 미리 제작된 감정 표현 방식은 정형화되어 있어 개인별 다양한 감정 표현에는 깊이가 부족하다는 한계가 있다. 곽면선(Kwak, 2021)의 연구에 따르면 한국인은 이모티콘을 감정을 표현하거나, 텍스트로 이루어진 대화에서 오해가 발생하지 않기 위해 사용한다는 점에서 텍스트 기반 커뮤니케이션에서 감정 표현의 한계가 나타났다. 본 연구에서는 텍스트 기반의 커뮤니케이션에서도 얼굴을 마주하고 대화하는 것과 같이 얼굴 표정을 통한 감정 표현 메신저를 제안하여 상대방과 대면하여 대화를 나누는 것처럼 직접적이고 자연스럽게 감정을 표현하는 방법을 탐색하고자 한다.

2. 관련 연구

2.1. 인간의 감정 분류와 얼굴 표정

감정 연구자들과 심리학자들은 보편적인 인간의 감정에서 문화적으로 특정한 복잡한 감정까지 다양한 감정 분류 모델을 정의해왔다. 에크만(Ekman, 1999)의 ‘Basic set of emotions’에 따르면 인간이 공통적으로 갖고 있는 보편적인 감정을 행복(happy), 놀람(surprised), 슬픔(sad), 공포(fearful), 분노(angry), 혐오(disgusted)로 분류하였고, 이는 얼굴 표정을 통해 나타난다고 제시하였다. 패럿(Parrott, 2001)은 ‘Emotions in Social Psychology’에서 인간의 감정 체계를 설명하고 사랑, 기쁨, 분노, 슬픔, 두려움, 놀라움이라는 6가지 단계의 감정 계층구조를 통해 분류하였다. 러셀(Russell, 2003)에 따르면 인간의 감정은 극과 극으로 매우 두드러질 수 있으며, 각 감정의 온도감이나 사람마다 느끼는 에너지가 모두 다르기에 심리적인 측면에서 개념적 틀을 발전시키고자 핵심 감정 주기율표를 설계하였다. 핵심 감정과 감정의 심리적 구조는 사람들이 감정과 그 맥락을 정확하게 해석, 예측 및 이해할 수 있게 해주기 때문에 HCI(human-computer interaction) 분야 전반에 걸쳐 사용되었다. 감정은 차원에 따라 공간에 위치시킬 수 있으며, 일반적으로 2차원 또는 3차원 공간에서 정의된다(Karbauskaite et al., 2020). 최초의 2차원 모델인 Russell의 Circumplex model은 원자가(valence)와 각성(arousal)으로 나누어 감정은 원형의 점으로 매핑되었으며, 중심점은 중립적인 감정을 나타낸다(Russell, 1980). 이후 러셀(Russell, 2003)이 제시한 핵심 감정의 요소는 쾌락(pleasure)-불쾌(displeasure), 활성화(activation)-비활성화(deactivation)의 2차원으로 이루어져 있는데, 다양한 핵심 감정이 어디에 위치하는지에 대해 핵심 정서(core affect) 모델로 제안하였다.

일반적으로 인간은 자신의 감정을 전달하기 위해 얼굴 표정, 목소리 억양, 제스처, 자세, 눈 맞춤 등 다양한 비언어적 기호를 사용한다. 이처럼 감정은 표정과 몸짓, 말투 등 다양한 방식으로 표현이 가능하며 이는 컴퓨터 언어학에서는 기쁨, 슬픔, 분노, 놀람, 증오, 두려움 등의 감정으로 표현될 수 있다. 특히 일상적인 커뮤니케이션에선 비언어적 표현인 얼굴 표정이 의사소통의 55%를 차지한다(Wiener & Mehrabian, 1968). 그러나 텍스트 기반 커뮤니케이션에서는 비언어적 요소가 결여되어 상대방의 감정을 파악하기 어려운 한계를 지닌다(Ko et al., 2007). 이러한 맥락에서, 에크만이 제시한 인간의 보편적인 6대 감정은 텍스트 커뮤니케이션에서 비언어적 요소의 부재를 보완하는 데 중요한 역할을 할 수 있다.

2.2. 텍스트 기반 커뮤니케이션의 감정 표현

텍스트 기반 커뮤니케이션이 일상생활에서 널리 활용되면서 대면하지 않고도 상대방의 감정 상태를 평가하고, 감정을 전달하는 것이 가능하게 되었다(Hancock et al., 2007). 특히 김주용 & 소연정(Kim & Soh, 2007)의 연구에서는 사람들이 이모티콘에 대해 텍스트 메시지의 한계를 보완하거나, 대화의 분위기를 위해 쓰인다고 한다. 하지만 이모티콘의 과도한 사용은 진지한 내용의 대화도 가볍게 느껴지게 만들고 자신의 감정이 잘 전달되지 않는다고 생각하여 진지한 대화 시에는 텍스트만 보내는 것이 가장 적합하다고 하였다(Kim & Soh, 2007). 사용자들은 상호 커뮤니케이션 상황에서 정확한 감정 전달이나 명확한 대화 내용 전달을 위해 여전히 텍스트를 선호하였으나, 텍스트는 감성적 가치가 부족하다는 한계점도 존재하였다. 사용자가 감정을 표현하기 위해 이모티콘을 사용하기도 하는데, 이모티콘은 화자의 목소리 톤이나 감정의 강도를 상세하게 전달하는 능력은 아직 부족하다고 보고 있기 때문이다(Zhe & Boucouvalas, 2002).

선행연구에 따르면 텍스트를 통해 감성적인 표현을 이끌어 낼 수도 있다. 손우성 & 남택진(Son & Nam, 2017)의 연구에서는 다양한 손글씨 패턴의 요소를 활용한 감정적 의사소통에 대한 가능성을 고려하였다. 이준환 외(Lee et al., 2006)는 키네틱(kinetic)의 역동적이고 표현적인 특성을 사용하여 텍스트의 정서적인 특성을 향상시킴과 동시에 시간이 지남에 따라 움직이거나 변하는 키네틱 타이포그래피(kinetic typography)를 통해 텍스트의 정서적 특성을 향상시킬 수 있음을 보여주었다. 이러한 접근 방식은 텍스트 기반 커뮤니케이션에서 서체의 변화를 통해 사용자에게 새로운 경험을 제공할 수 있다. 서체가 단순히 텍스트를 전달하는 기능을 넘어서 감정과 정서를 표현하는 데에도 중요한 역할을 할 수 있음을 시사한다.

2.3. 서체에서 느껴지는 감정

인간은 서체로부터 느껴지는 감정의 정도를 평가할 수 있다. 연구자들은 이를 서체의 기능과 더불어 서체가 만들어내는 인상 또는 개성이라고 제시하였다(Amare & Manning, 2012; Moon & Chang, 2015). 최새미 & 아이자와(Choi & Aizawa, 2019)의 연구에서는 모바일 메신저에서 서체를 바꾸어 감정을 표현하는 방법을 통해 감정 표현의 확장을 확인하였다. 또한, 서체를 통해 특정한 느낌을 전달받을 수 있으며, 각 서체의 고유한 스타일을 통해 전달된 텍스트는 정서에 영향을 미친다고 하여 서체의 정서적 효과에 관해 연구하였다(Choi & Aizawa, 2019). 한편, 서체를 통해 정서적 감정 표현과 비언어적 요소들이 구현될 수 있다는 점도 강조되었다. 이준웅 외(Lee et al., 2008)의 연구에서는 문화적 배경에 따라 감정의 경험과 표현 방식이 다르기 때문에 한국인의 개별적인 정서가 어떠한 특정 감정을 표현하는지에 대한 이해가 필요하다고 언급하였다. 이준환 외(Lee et al., 2014)의 연구에 따르면, 정서에 대해 매 순간 사람들이 느끼는 것을 다양한 심적 상태로 소통하기 때문에 커뮤니케이션에 있어서 중요한 부분으로 보았다. 이주원 & 전수진(Lee & Jun, 2017)의 연구에서는 서체의 형태적 요소에 따라 사용자가 다양한 감정을 느끼고 특정한 감정의 규칙이 존재하였으며, 설문조사를 통해 서체 감정 측정 결과가 사용자의 서체 선택에 있어 감성을 기준으로 작용한다는 것을 제시하였다. 손은미 & 이현주(Shon & Lee, 2008)의 연구에서는 디지털 매체에서 감성적인 언어 활용을 위한 글꼴 분류를 통해 서체가 감성에 미치는 영향과 요인들을 탐구하였다. 감성공학의 방법론을 응용하여 한글의 글꼴 분류를 감정 어휘를 이용해 글꼴의 이미지 측면에서 접근하였고, 글꼴의 형태적 조형 요소와 감정 어휘 간의 상관관계를 분석하였으며 부리(serif)의 유무와 굵기 요인이 감정 어휘에서 가장 큰 영향을 미친 것으로 나타났다(Shon & Lee, 2008). 또한, 서체의 형태적 요인이 기쁘다, 슬프다 등과 같은 긍정적 또는 부정적인 감정 반응을 유발하는 것으로 확인하였다(Shon & Lee, 2008; Choi et al., 2016). 앞선 선행연구들은 서체가 감정 전달에 있어 중요한 요소로 작용할 수 있음을 드러내고 있다.

3. 연구 방법

본 연구는 텍스트 기반 커뮤니케이션에서 서체를 활용한 감정 표현 방법을 모색하고, 이를 기반으로 메신저 ‘EmoChat’을 개발하여 사용자 경험을 분석하였다. 먼저, 문헌조사를 통해 인간의 보편적인 감정과 표현을 조사하고, 한글 서체의 형태적 요소를 분석하여 50개의 서체를 선정하였다. 감정 서체 설문조사를 통해 각 서체에서 느껴지는 감정과 감정 요인을 조사하여 감정과 서체를 30개 세트로 매칭시켜 프로토타입을 제작하였다. 이후 사용자 평가를 통해 프로토타입의 사용성을 검토하고, 사용자 경험을 정성적으로 분석하였다.

3.1. 연구 문제

연구 문제를 통해 텍스트 기반 커뮤니케이션에서 서체를 활용한 감정 표현 메신저 EmoChat을 프로토타입으로 제작하여 사용자 평가를 진행하고자 한다. 선행연구를 통해 텍스트 기반 커뮤니케이션에서 나타나는 감정 표현에 대해 이론적 고찰을 한다. 사용자들이 메신저에서 어떻게 감정 표현을 하고 있는지, 감정 표현 관련 문제점과 한계점은 무엇인지 등에 대해 알아보고자 한다. 한글 서체를 형태적 요소로 분류하여 실험에 사용할 대표 서체를 선정하고 설문조사를 통해 각 서체에서 느껴지는 감정과 감정 요인을 알아보았다. 이를 정서 단어와 매칭하여 프로토타입에 사용할 감정 서체를 설계하였다. 메신저에서 감정 표현을 하기 위해 사용자의 얼굴 표정 인식과 정서 단어 선택 기능을 제공하는 EmoChat을 제작하여 사용성 평가를 진행하였다. 또한, 기존 메신저 서비스와 비교하여 감정 표현이 더 풍부해졌는지 심층 인터뷰를 통해 정성적으로 알아보고자 하였다. 이를 위한 연구 문제 3가지는 다음과 같다.

RQ 1. 텍스트 기반 커뮤니케이션인 메신저 서비스에서 나타나는 감정 표현의 문제점은 무엇인가?

RQ 2. 한글 서체에서 느껴지는 감정과 감정요인, 정서는 어떠한가?

RQ 3. 감정 표현 메신저 EmoChat에서 제공하는 사용자 경험은 어떠한가?

3.2. 실험 설계

먼저 서체에 따른 사용자가 느끼는 감정을 평가하는 실험 연구를 진행하였다. 실험에서 사용될 서체를 선정하기 위해 다양한 서체 구성 요소인 부리, 굵기, 점, 삐침, 굴림 등을 통해 분류하고, 서체의 기본 이미지를 사용자에게 제시했을 때 느껴지는 감정과 감정 요인을 설문조사를 통해 측정하였다. 설문조사 분석 결과를 토대로 각 서체에서 가장 높게 나타나는 감정을 대표 감정으로 매칭하였다. 또한, 사용자가 더 세분화된 감정을 표현하기 위해 사용되는 정서 단어들을 제공하고자 감정과 정서에 대한 다차원척도법(Multidimensional Scaling, 이하 MDS) 분석을 진행하였다. 이를 통해 서체를 군집화하고, 감정 간의 거리 유사성을 기반으로 정서 단어와 매칭시켰다. 마지막으로 사용자의 얼굴 표정을 인식하여 감정을 감지하고, 사용자가 감정을 더 상세하게 정서 단어로 선택하여 대면 상황에서의 대화와 같이 감정을 보다 자연스럽고 풍부하게 표현하는 것을 목표로 하였다.

3.3. 서체의 감정, 감정요인 평가 지표

서체의 기본 이미지를 통해 사용자가 느끼는 감정과 감정 요인을 평가하는 실험 연구이다. 설문조사 참여자는 디자인 전공 게시판 및 관련 커뮤니티에 모집 문건을 게시하여 총 40명을 모집하였다. 본 연구에서 측정에 사용될 한글 서체를 선정하기 위해 Google Fonts의 한글 서체, 서체 검색 사이트의 무료 서체를 종합하여 총 188개를 선정하였다. 서체를 선정하기 위한 분류 체계는 글꼴 디자인에 기반하여 이를 제시한 선행연구를 참고하였다(Kim & Lim, 2017). 신윤진(Shin et al., 2005)의 연구에서는 서체의 형태적인 특성만을 대상으로 한정하여, 한글 서체의 형태 표현 요소는 점, 줄기, 부리, 맺음, 꺾임, 굴림, 삐침, 상투 등으로 고유의 특성을 설명하였다. 이를 바탕으로 서체의 형태 요소가 동일하거나 유사한 서체들을 묶어 중복 요소를 제외하였고, 2차례 분류를 통해 최종적으로 50개의 한글 서체를 선정하였다. 감정은 에크만(Ekman, 1999)이 제시한 6대 감정(행복, 놀람, 슬픔, 공포, 분노, 혐오)을 기반으로 조사하였다. 이준환 외(Lee et al., 2014)의 키네틱 타이포그래피 연구에서는 움직이는 글자를 본 후 느껴지는 감정 요인(긍·부정 정도, 에너지의 높낮이)을 측정하였다. 본 연구에서도 서체의 감정을 긍·부정 정도와 에너지의 높낮이, 6대 감정으로 측정하고자 하였다. 이후 50개의 서체 기본 이미지를 활용하여 설문지를 구성하였다. 감정 평가 지표는 해당 서체가 6대 감정을 표현하기에 적절한지 Likert 7점 척도(1점 전혀 적절하지 않다 - 7점 매우 적절하다)로 평가하고, 판단한 기준에 대해 주관식 답변을 작성하도록 하였다. 감정 요인 평가 지표도 동일하게 긍·부정 정도와 에너지를 Likert 7점 척도(1점 매우 부정적/낮은 에너지 - 7점 매우 긍정적/높은 에너지)로 평가하고, 판단 기준에 대한 주관식 답변을 수집하고자 하였다.

4. 서체를 활용한 감정 표현 메신저 EmoChat

4.1. 서체와 6대 감정과 긍·부정, 에너지의 관계

설문조사를 통해 도출한 각 서체를 통해 느껴진 6대 감정과 긍·부정, 에너지의 관계를 파악하기 위해 Pearson 상관분석(correlation analysis)을 시행했다(Table 1). 통계 분석 결과 서체와 6대 감정, 긍·부정, 에너지 모두 유의 확률이 0.001을 넘는 것으로 확인하여 유의미한 설문조사 결괏값으로 검증하였다.

먼저 서체를 통해 느껴진 6대 감정 간의 상관관계를 알아보았다. 분석 결과 공포와 혐오(r=0.608, p=0.000)는 상관관계 중 가장 높은 정(+)적 상관관계를 나타냈다. 분노와 공포(r=0.589, p=0.000), 혐오와 분노(r=0.560, p=0.000)도 높은 정(+)적 상관관계를 가졌다. 행복과 혐오(r=-0.142, p=0.000)는 상관관계 중 가장 높은 부(-)적 상관관계를 나타냈다. 행복과 공포(r=-0.118, p=0.000)도 높은 부(-)적 상관관계를 가졌다. 공포, 혐오, 분노의 서체는 감정 간 유사한 상관관계를 가졌으며 이들은 행복의 서체와는 가장 먼 상관관계를 가지고 있었다.

6대 감정과 긍·부정 정도의 관계를 알아본 결과 행복(r=.397, p=.000)과 놀라움(r= .171, p=.000)은 긍·부정과 정(+)적 상관관계를 나타냈다. 반면, 슬픔(r=-.137, p=.000), 혐오(r=-.337, p=.000), 분노(r=-.233, p=.000), 공포(r=-.312, p=.000)는 긍·부정과 부(-)적 상관관계를 나타냈다. 행복, 놀라움은 긍정적인 서체로 슬픔, 혐오, 분노, 공포는 부정적인 서체에 가까운 것으로 해석할 수 있다.

6대 감정과 에너지 정도의 관계를 알아본 결과 행복(r=.207, p=.000)과 놀라움(r= .164, p=.000)은 에너지 정도와 정(+)적 상관관계를 나타냈다. 반면, 슬픔(r=-.080, p=.000), 혐오(r=-.133, p=.000), 분노(r=-.083, p=0.000), 공포(r=-.133, p=0.000)는 에너지 정도와 부(-)적 상관관계를 나타냈다. 에너지 정도는 긍·부정 정도와 마찬가지로 행복, 놀라움은 에너지가 높은 서체로 슬픔, 혐오, 분노, 공포는 에너지가 낮은 서체에 가까운 것으로 나타났다. 분석한 6대 감정과 긍·부정, 에너지의 상관관계와 동일한 기준을 가진 Russell의 2차원 감정 순환 모델이 서체의 6대 감정과 긍·부정, 에너지의 상관관계에서 해석된 분류와 동일한 구조를 지니고 있어 설문조사에 대한 타당성을 확인하였다.

4.2. 서체의 감정 및 정서 단어 분류

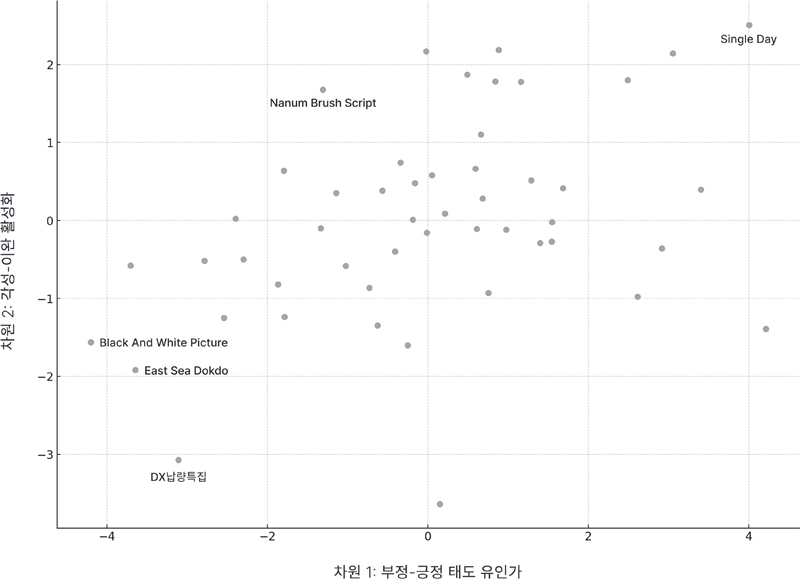

Likert 7점 척도로 진행한 설문조사에서 나온 각 6대 감정별 표준값이 가장 높은 서체를 해당 감정의 대표 서체로 지정하였다. 행복은 6.18점의 ‘Single Day’로 긍·부정 값은 6.25점, 에너지값은 5.3점이며, 놀람은 4.68점의 ‘Mapo홍대프리덤’으로 긍·부정 값은 3.8점, 에너지값은 4.65점으로 놀람의 경우 감정, 긍·부정, 에너지값 모두 상대적으로 낮은 점수를 기록하였다. 슬픔은 5.15점의 ‘Nanum Brush Script’로 긍·부정 값은 4.65점, 에너지값은 4.13점이며, 공포는 6.2점인 ‘Black And White Picture’로 긍·부정은 2.65점, 에너지값은 3.47점을 기록했다. 분노는 4.9점인 ‘East Sea Dokdo’로 긍·부정은 2.78점, 에너지값은 3.55점이며, 혐오는 5.73점의 ‘DX납량특집’으로 긍·부정 값은 2.27점, 에너지값은 3.6점으로 나타났다. 지정된 감정의 대표 서체는 다음과 같다(Table 2).

이준웅 외(Lee et al., 2008)의 연구에 따르면 한국인이 정서 표현에 자주 사용하는 단어를 기반으로 정서의 범주화와 기본 구성 차원을 밝혔다. 정서 단어 목록의 경우 1998년 연세대학교 언어정보개발연구원에서 제작한 ‘현대 한국어의 어휘 빈도’ 자료집에 기초하였으며, 이를 유사성 평가를 진행하여 군집분석 방법을 활용한 정서의 기본 범주를 도출하였다.

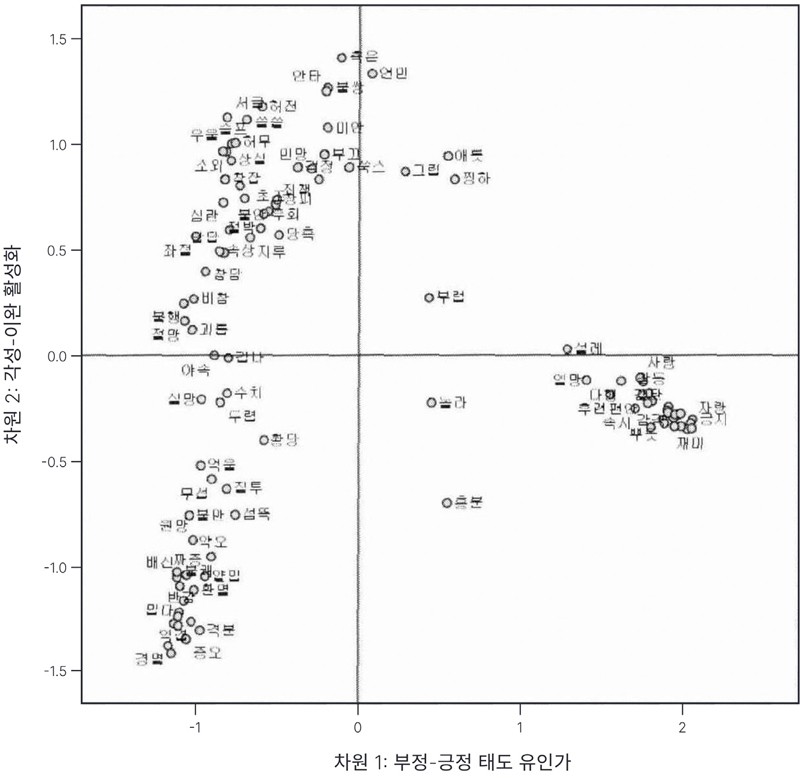

MDS 분석을 이용한 정서의 구성 차원에 대한 군집분석은 정서의 의미적 차원을 드러낸다. 이를 X축에선 부정-긍정 태도 유인가, Y축에선 각성-이완 활성화의 2차원 구조를 도출하여 분류된 정서들을 포괄하여 설명하였다(Figure 1). 본 연구에서는 이를 활용하여 감정과 정서 단어와의 연관성을 찾아 분류하였다.

본 연구에서는 한국인의 정서 단어를 범주화하고 의미적 차원을 군집 분석한 선행연구를 바탕으로 설문조사를 진행하여 50개의 서체를 선정하였다. 이 서체들에 대해 6대 감정, 긍·부정, 에너지값을 포함한 서체 당 8개의 통계 결괏값을 도출하였다. MDS 분석을 통해 서체 간의 유사성을 거리로 변환하였고, 이를 통해 유사한 감정의 서체를 군집화하고 이후 정서 단어와 매칭하는 데 사용하였다. 분석에는 Python 3.11.3 버전의 Sklearn, Matplotlib, Pandas 라이브러리를 활용하였으며, 분석 결과 선행연구와 동일한 축의 2차원 구조(x축: 긍정- 부정 차원, y축: 각성-이완 차원)를 도출하였다(Figure 2).

MDS 분석 결과를 통해 각 서체의 가장 높은 감정 점수와 x, y 위칫값의 거리 유사성을 기반으로 정서 단어와 매칭 작업을 진행하였다. 평균 이하의 표준 점수를 가진 7개의 서체는 감정이 명확히 드러나지 않는다고 판단하여 매칭 작업에서 제외하였다. 서체의 8가지 요인을 고려하였기 때문에 서체가 하나의 대표 감정으로 명시되지 않았으며, 이에 따라 중복된 감정을 가지는 서체들이 존재하였다. 분석 결과, 감정당 5개의 정서 단어가 추출되었다(Table 3). 이를 통해 사용자는 메신저에서 세부적인 정서를 선택할 수 있는 요소를 제공받아 더 풍부한 감정을 표현할 수 있게 된다.

4.3. EmoChat 프로토타입

메신저에서 사용자의 감정을 반영해 대화를 주고받는 방법에 대한 기술적인 검토를 위해 프로토타입을 제작하여 실제 사용자의 표정을 통해 드러난 감정이 제대로 전달되는지 확인하였다. 사용자가 선택한 정서에 따라 매칭시켜 둔 서체를 텍스트에 적용해 표정에서 감정을 감지하는 것뿐만 아니라 사용자가 전달하고 싶은 세부적인 정서 단어를 제공하여 서체를 통해 감정을 전달하는 메신저를 개발하였다.

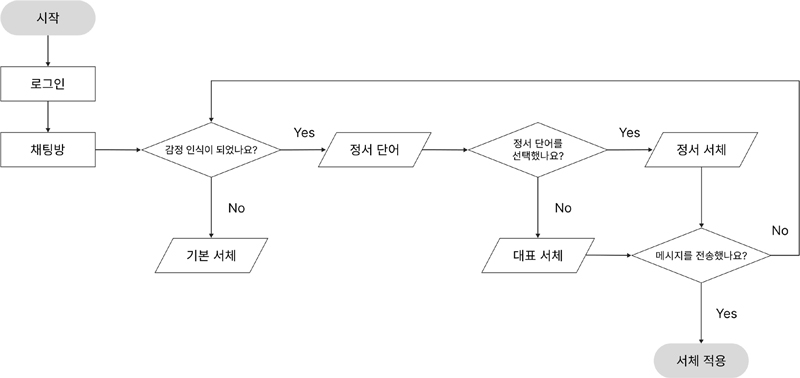

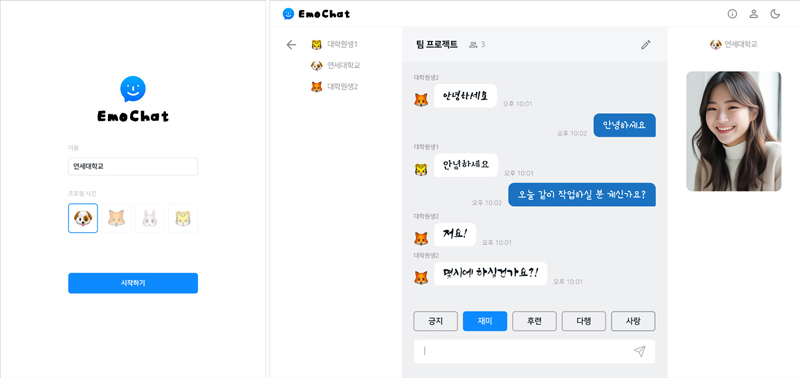

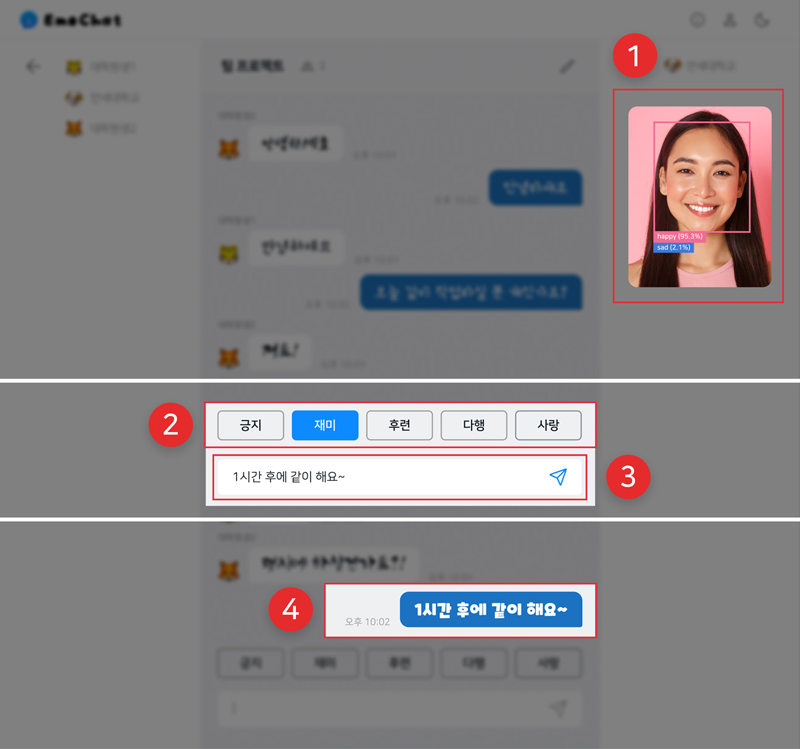

본 연구에서 필요한 주요 화면은 프로필, 채팅방 2가지로 구성되어 있다. 사용자가 메신저에 접속하면 사용자 설정 화면에서 이름과 프로필 사진을 설정할 수 있다. 메신저 내 서체 적용 방식은 다음과 같다. 카메라에서 사용자의 표정을 감정으로 인식하여 각 6대 감정에 맞는 정서 단어를 선택하도록 제시한다. 감정 인식 모델이 사용자의 감정을 인식하지 못하거나, 감정이 드러나지 않는 중립(neutral)의 경우 메신저의 기본 서체인 ‘Nanum Square’가 적용된다. 사용자가 메시지를 입력하지 않은 상태에선 실시간으로 감정을 감지하기 때문에 표정이 인식되지만, 사용자가 메시지를 전송하지 않을 경우 표정이 바뀌거나 6프레임(frame) 이상 다른 감정이 인식될 경우 해당 감정의 정서 단어로 변경되도록 하였다. EmoChat의 전체 플로우(flow)는 다음과 같다(Figure 3).

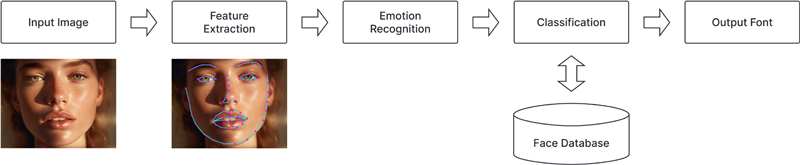

인간의 얼굴 표정은 의사소통에서 가장 중요한 요소이기 때문에 대면 상황처럼 자연스러운 표정을 인식하여 메신저에 담아내기 위해 표정을 통한 감정 인식 모델을 주요 기능으로 설계하였다(Wiener & Mehrabian, 1968; De & Saha, 2015; Ekman et al., 1987). 최근 이미지 인식 기술이 급격히 발전하며 이미지나 영상 속에 등장하는 인물을 찾거나 인물과 관련된 정보를 추출하는 기술에 많은 발전이 있었다. 특히, 표정에서 감정을 추출하는 얼굴 표정 인식 기술이 깃허브(GitHub) 등을 통해 오픈소스 소프트웨어로 제공되기 시작하며 관련 연구도 활발히 이루어지고 있는 상황이다(Shan et al., 2009; Revina & Emmanuel, 2021).

EmoChat 메신저 프로토타입에서 사용된 얼굴 표정 감지 모델인 ‘face-api.js’는 TensorFlow 기반의 JavaScript 라이브러리 오픈소스 딥러닝 모델이다. 이는 실시간 객체 탐지 알고리즘인 ‘YOLO(You Only Look Once)’의 베이스 모델로 그중 YOLO V2를 6대 감정(happy, surprised, sad, fearful, angry, disgusted)과 중립(neutral) 감정으로 파인 튜닝(fine tuning)한 모델이다. 특히 Tiny Face Detector(소형 얼굴 인식기)를 구현하여 198KB의 가벼운 크기가 장점으로 웹(Web) 개발 환경에 최적화하여 빠르게 표정을 인식하고 감정값으로 나타낼 수 있다. 모델은 사용자의 카메라를 통해 표정을 실시간 이미지로 인식하여 특징을 도출한다. 이를 학습된 데이터베이스를 통해 감정으로 분류하고, 서체에 적용되어 출력되도록 설계하였다(Figure 4).

프로토타입 제작에 사용한 Face Expression Recognition(얼굴 표정 인식) 모델은 기본적으로 사용자의 얼굴에서 눈썹, 눈, 코, 입, 얼굴의 외곽을 인식하며, 표정에 대한 6대 감정(happy, surprised, sad, fearful, angry, disgusted)과 중립(neutral)으로 구성되어 있다. 에르타이 외(Ertay et al., 2021)의 연구에서는 해당 모델을 사용하여 원격 환경 커뮤니케이션에서 얼굴 표정 감지를 통한 감정을 시각화하여 데이터 포인트를 수집하였다. 뉴로마케팅(Neuromarketing)에서 사용자의 감정을 탐지하여 광고 자료를 분석한 인공지능 연구에서는 광고를 볼 때의 사용자 표정을 빠르게 인식하기 위해 해당 모델이 사용되었다(Filipovic et al., 2019). face-api.js는 에크만의 6대 감정에 기반한 분류를 통해 표정을 감지하고, 가벼운 리소스와 빠른 표정 인식도를 나타내기 때문에 웹 메신저 프로토타입을 구현하기 위한 모델로 사용하기에 적합하다고 판단하였다.

EmoChat은 Emotion(감정)과 Chat(대화)의 합성어로 감정을 표현하여 대화를 나누는 메신저라는 의미를 나타냈다. 로고는 메신저를 대표하는 말풍선 아이콘에 감정 표현을 의미하는 얼굴 표정인 눈, 코, 미소 짓는 입 모양을 넣어 EmoChat의 얼굴 표정 감지 기능을 표현하였다. 타이포그래피는 자연스러운 손글씨체를 사용하였고, 컬러는 사람들과 대화하며 웃는 표정을 짓고 있는 사람에서 느껴지는 활기찬 분위기를 표현하는 푸른색 계열을 사용했다. 사용자가 쉽고 편리하게 사용할 수 있도록 기존 연구에서 제시된 레이아웃을 고려하여 친숙한 메신저 인터페이스를 제안하고자 한다. 메신저 서비스를 비교 분석한 연구에 따르면 페이스북, 바이버, 스카이프, 카카오톡, 라인의 메신저 레이아웃에서 공통으로 사용되는 기능 요소와 UI 디자인 요소를 제시하였다(Youn et al., 2017). EmoChat의 프로토타입은 로그인, 채팅방 2개의 화면으로 이루어져 있어 사용자가 쉽게 순차적으로 사용할 수 있다(Figure 5).

사용자로부터 인식된 대표 감정에 기반한 정서 단어를 5개씩 제공하였다. 사용자의 감정이 인식되면 메시지 입력창 상단에 해당 감정의 정서 단어 선택 버튼이 나타나며, 사용자는 자신의 감정에서 더 상세하게 전달하고 싶은 정서 단어를 선택할 수 있으며, 이를 통해 서체가 더 다양하게 표현된다. 예를 들어 사용자의 표정에서 ‘행복’ 감정을 인식한다면 ‘긍지, 재미, 후련, 다행, 사랑’ 5개 정서가 제시되는데, 이중 사용자가 ‘재미’를 선택하게 되면 행복한 감정 중에서도 재미에 가까운 감정의 서체가 출력되는 것이다(Figure 6).

4.4. 실험 계획

연구 대상자 모집 방법은 앞선 실험과 동일하게 모집 문건을 게시하여 온라인 커뮤니티, 카페, SNS를 통해 모집하였다. 가족, 연인, 친구, 동료 관계에 해당하는 그룹별로 상대방과 함께 신청하도록 기재하였으며 새로운 사람 관계의 경우 개인으로 신청받아 연구자가 그룹을 만들어 구성하였다. 연구 대상자는 웹이나 모바일에서 메신저 서비스를 사용해 본 경험이 있는 20~30대 남녀이며, 이를 사용해 본 경험이 없는 사람은 제외하였다. 사회적 관계에 따라 사용자를 분류하여 모집하였으며, 총 24명(남성 12명, 여성 12명)을 대상으로 사용성 평가를 진행하였다. 참여자들은 EmoChat 프로토타입에 접속하여 채팅방에서 선택한 주제에 대해 상대방과 자유롭게 대화를 나누는 경험해 본 뒤, 심층 인터뷰를 진행하여 감정 표현과 서체에 대한 의견을 제시하였다. 질문지는 평소 대면 상황과 메신저에서의 대화 및 감정 표현과 EmoChat의 사용 경험 및 기존 메신저와 비교하여 질문하였고, 상대방과의 관계가 EmoChat을 사용하는 데 영향을 미치는지에 관한 질문으로 구성하였다. 사용자 평가 참여자 간의 사회적 관계는 다음과 같다(Table 4).

참여자는 편안한 환경에서 연구자가 직접적으로 지켜보지 않을 때, 자연스러운 행동과 대화가 이루어지기 때문에 프로토타입을 웹에 배포하여 혼자만의 공간에서 자유롭게 대화하도록 제안하였다(Choi & Aizawa, 2019). 참여자들에게 제공한 대화 주제는 AI Hub의 ‘주제별 텍스트 일상 대화 데이터’의 한국인이 일반적으로 나누는 일상 대화의 주제 20개로 선정하였다. AI Hub에서 제공하는 해당 데이터는 5개의 메신저 플랫폼에서 2021년 텍스트 데이터 134,263건의 자유로운 일상 대화를 수집하여 한국어로 나눈 일상 대화의 주제, 화행 등 정보를 담은 데이터 세트다(Lee, 2021). 이는 한국어로 나눈 자유 대화 및 다양한 일상 주제 대화 텍스트 데이터 수집이 목적인 점과 본 연구와 동일한 메신저 플랫폼을 통해 대화를 분석하였기에 실험에 사용할 주제로 적합하다고 판단하였다. 또한, 신현규 외(Shin et al., 2023)는 챗봇과 같은 대화 시스템에 한국어에서 상식적인 내용을 담은 문장은 무엇을 고려해야 하는지에 대해 논의한 연구로 주요 키워드를 중심으로 일상생활 대화의 중요도를 파악하였다. 이에 AI Hub에서 제공하는 ‘텍스트 일상 대화 데이터’의 대화 주제가 한국인이 보편적으로 많이 사용하는 대화의 주제인 것을 확인하였다. 그룹별로 대화 주제 2개를 선택하도록 하였고, EmoChat에서 해당 주제에 대해 각 10분씩 대화하도록 가이드를 주었다.

4.5. 사용자 평가

EmoChat의 서체를 활용한 감정 표현 방식이 상대방과 상호 작용하는 데 도움이 되었는지 Likert 7점 척도로 평가하여 기능의 유용성에 대해 알아보았다. 또한, EmoChat에서 상대방에게 감정을 더 다양하게 표현할 수 있었는지, 상대방의 감정을 더 잘 느낄 수 있었는지에 대해 평소 사용하고 있는 메신저와 비교 평가하도록 하였다. 프로토타입 사용 경험에 대한 평가 항목은 3가지이며 참여자들의 평가 점수의 평균값은 다음과 같다. 기능의 유용성은 평균 5.7점, 기능을 통한 표현의 다양성은 평균 5.5점, 감정의 공감성은 평균 5.1점으로 전체 평균 5.46을 기록하여 전반적으로 각 요소가 유효함을 확인할 수 있다.

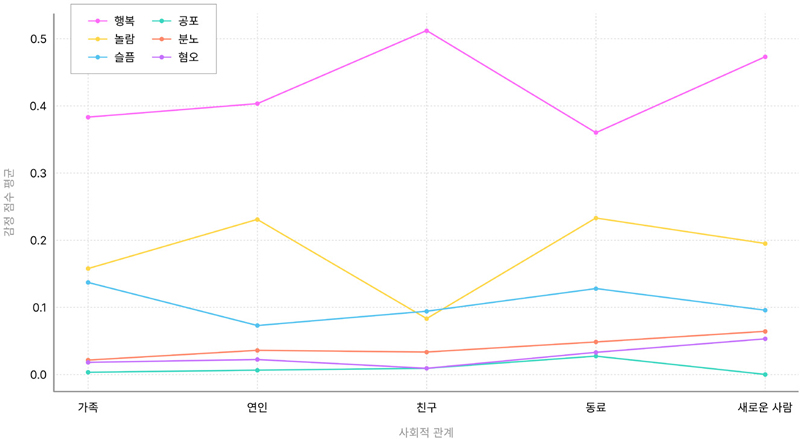

프로토타입에서 인식된 참여자들의 감정과 선택한 정서를 확인하고자, 실험에서 수집된 3,926개의 메시지 데이터를 통해 사회적 관계와 감정 표현에 대해 분석하였다. 본 연구에서 사용된 YOLO 모델은 표정에서 감정이 인식될 때, 대표 감정의 강도가 0(해당 감정이 전혀 나타나지 않음)과 1(해당 감정이 매우 강하게 나타났음) 사이로 측정돼 사용자가 얼굴에서 표현한 감정의 강도 측정이 가능하다(Figure 7).

행복 감정은 모든 사회적 관계에서 가장 높게 나타났으나, 그중에서도 친구 관계에서 평균 0.512로 가장 높게 측정되었으며, 다음으로 새로운 사람 관계에서 평균 0.473으로 높게 측정되었다. 인터뷰 결과 새로운 관계의 참여자들은 EmoChat에서 상대방의 감정이 서체로 나타나는 방식 덕분에 짧은 시간 안에 빠르게 감정 교류를 경험할 수 있으며 흥미롭다고 느꼈다. 이는 특히 새로운 관계에서 EmoChat이 유용하다고 해석할 수 있다.

5. 연구 결과

평소 참여자들의 대면 상황과 메신저에서의 감정 표현 방법에 대해 알아보고, EmoChat에서는 어떠한 차별점이 있는지 비교하여 질문하였다. 또한, EmoChat의 사용 경험에 대해 사용자가 정서를 선택하고 메신저로 대화하면서 더 섬세하고 풍부한 감정 표현이 가능했는지를 중점적으로 알아보았다.

5.1. 대면 상황에서의 감정 표현

참가자들은 대면 상황에서의 감정 표현 방법에 대해 표정과 말투, 목소리 톤, 어조의 변화와 같이 비언어적인 표현을 주로 사용한다고 했다. 평소 자신의 감정을 솔직하게 표현하는 사람들은 상대방에게 직접적인 말을 통해 표현하였고, 반면 자신의 감정을 의도적으로 숨기거나 드러내지 않기 위해 표현을 거의 하지 않는다는 유형도 있었다.

“표정은 변화가 거의 없으나 말할 때 오히려 표현이 나온다. 짜증 나거나 화가 났을 때 얼굴에선 드러나지 않지만, 말의 속도가 빨라지거나 악센트가 생기는 편이다.” (P4)

“의도하지 않게 표정에서 드러나기도 한다. 긍정적인 감정은 대부분 표출하려고 하고, 부정적인 감정은 숨기려고 한다.” (P19)

대면 상황에서 상대방의 감정을 알아차릴 땐 표정과 말투를 가장 주시한다고 답변하였다. 특히 상대방의 평소와 다른 미세한 변화를 확인하면 감정의 변화가 있다고 생각하였다. 이처럼 대면 상황에서 감정 표현 방식은 개인적 차이가 뚜렷하여 비언어적 표현과 언어적 표현이 다양하게 사용되고 있었다.

“표정이나 눈썹을 많이 본다. 말투에서는 화나면 목소리에서 톤이 낮아지고, 기쁘면 높아지는 것에서 감정의 변화를 느낀다.” (P3)

“얼굴을 마주하면서 대화하다 보니, 사람마다 다르겠지만 표정과 목소리는 웬만해서 숨기기 어렵다고 생각한다.” (P4)

대면 상황에서 서로 간의 감정을 오해한 경험에 대해선 상대방의 말과 표정이 불일치할 때를 언급하였다. 또한 본인의 감정을 숨기려고 할 때도 마찬가지로 상대방이 감정을 오해하거나, 말의 의도를 잘못 파악하여 오해하는 경우도 발생하였다.

“말과 표정이 다를 때 오해한다. 텍스트만 보면 명확한데, 표정과 말이 불일치한 것을 동시에 보고 들으면 오해하게 된다.” (P21)

5.2. 메신저에서의 감정 표현

참가자들은 평소 메신저에서 감정 표현을 할 때 이모티콘과 이모지를 주로 사용하였다. 또한 ‘ㅋㅋ’, ‘ㅠㅠ’, ‘ㅡㅡ’와 같이 의성어를 자음으로 표현하거나, 느낌표나 마침표, 물결과 같은 문장 부호를 사용한다고 답변하였다. 사용하는 이유는 메신저에서 텍스트만 보내게 되면 딱딱해 보이기 때문에 좀 더 부드럽게 감정을 전달하기 위한 표현의 수단이라고 하였으며, 이모티콘을 자신의 표정을 대신해서 전달하는 용도로 사용하였다. 또한 텍스트만으로 감정을 표현하기에 한계가 있기 때문에 이모티콘을 사용한다고 답변하였다.

“메신저에서 ‘감사합니다’를 보낼 때 느낌표나 물결, 이모티콘을 써서 감정을 극대화한다. 텍스트만 보내면 좀 딱딱하고 내용이 다 표현되지 않은 느낌이 든다.” (P4)

“오로지 텍스트만 보내면 상대방의 해석에 따라 안 좋게 볼 수도 있다고 생각한다.” (P5)

대면 상황과 마찬가지로 부정적인 감정의 표현은 지양하였으며, 긍정적인 감정은 최대한 표현하고 드러낸다고 하였다. 또한, 메신저의 답장 속도나 단답형인지 장문형인지도 상대방의 감정을 파악하는 요소이다. 하지만 대면 상황과 달리 메신저에서는 실시간으로 얼굴을 마주하고 대화를 나누지 않기 때문에 상대방의 감정을 파악하기 더 어려운 점을 언급하였다. 특히 메신저에서 이모티콘 등을 거의 사용하지 않고 텍스트로만 보내는 상대방의 경우 감정을 알아차리기 어렵기 때문에 감정을 오해하는 경우가 더 높았다.

“내 말에 상대방이 되묻는 말을 하면 의도를 파악하기 어렵다. 얼굴 표정이 보이지 않아서 ‘혹시 기분이 안 좋나?’라고 오해할 때가 있다.” (P7)

“텍스트만으로 감정을 파악하긴 어렵지만, 특징적으로 장문의 메시지를 보낸다던가 답장이 빠르게 오는 거로 유추할 수는 있다.” (P2)

참가자들은 대면과 메신저에서 대화의 차이점에 대해 텍스트 기반 메신저에서 나타나는 실제 표정과 감정의 불일치와 정형화된 표현의 사용을 보였다. 예를 들면 ‘ㅋㅋ’ 등을 자주 사용하는 것에 대해 텍스트 기반 커뮤니케이션에서의 정형화된 표현이라고 보고 있었으며, P12는 텍스트만 보내면 딱딱해 보이니까 ‘ㅋㅋ’을 무조건 붙여서 보내야 한다는 의무감이 든다고 하였다. 마찬가지로 P17은 무표정인데 ‘ㅋㅋ’을 사용하는 경우가 많다고 했다. 이처럼 메신저를 사용할 때 기본적으로 설정된 서체의 딱딱해 보이는 인상으로 인해 서로 간의 오해가 발생하는 것을 줄이고자 이모티콘이나 이모지, 문장 부호 등을 추가로 사용하였다. 특히 감정을 부드럽게 전달하고 긍정적인 감정을 극대화하고자 사용했고, 친밀감을 표현하는 용도이기도 했다. 또한, 메신저에서는 대면과 달리 즉시성이 낮아 비교적 감정을 숨기기 쉽기 때문에 상대방의 감정을 알아차리기는 더 어렵다고 느꼈다. 텍스트 기반 커뮤니케이션에서 나타나는 한계점 중 텍스트로 인한 오해가 기존 메신저에서 발생하는 것을 확인했다.

5.3. EmoChat에서의 감정 표현

참여자들은 EmoChat에서 자유롭게 상대방과 대화하고 얼굴 표정을 통해 서체가 적용되는 경험을 통해 서체로 감정을 표현할 수 있다고 하였다. 특히 기존의 메신저에서 텍스트만으로 전달되지 않는 감정이 본인의 실제 표정으로 전달할 수 있는 점이 흥미롭다고 하였다.

“감정 표현이 자유롭게 글로 나타나는 것 같았다.” (P20)

“내 감정에 적합한 정서를 찾아서 표현하려다 보니까 확실하게 내 감정을 생각하고 보내게 된다. 그래서 감정 전달을 더 잘할 수 있었다.” (P17)

서체의 변화로 상대방의 감정을 풍부하게 느낄 수 있었다고 언급하였다. 특히 서체가 변화하는 것에 시선이 가기 때문에 텍스트와 대화에 더 집중할 수 있었다고 평가했다. 또한, 실제 내 표정이 인식되어 전달되니까 앞서 언급한 메신저에서의 표정과 감정의 불일치가 개선되었다고 느꼈으며, 감정 표현의 즉시성으로 인해 솔직한 대화가 가능하다고 평가하였다.

“대화의 즐거움이 배가 되었다. 진짜 내가 웃고 있어야 서체로 표현되니까 좋다. 평소엔 무표정에서 ‘ㅋㅋ’을 써야 하는 상황이 많기 때문이다.” (P16)

“기존에 텍스트로는 다 전달되지 않는 것도 표정을 함께 전해주니까 솔직하고 다양하게 표현할 수 있었다.” (P18)

본 연구에서 설문 조사한 서체를 Pearson 상관분석을 통해 서체와 6대 감정, 긍·부정, 에너지 간에 유의미한 관계가 있음을 확인하였으며, 특히 공포와 혐오 사이에는 가장 높은 양의 상관관계가, 행복과 혐오 사이에는 가장 높은 음의 상관관계가 나타났다. 이에 관련하여 참가자들은 EmoChat에서 대화하면서 메시지의 맥락과 서체가 명확했던 점이 인상 깊었다고 하였다. 감정과 메시지를 함께 확인할 수 있어 직관적으로 이해할 수 있었고, 상대방의 말과 감정이 더 잘 전달되었다고 느꼈다.

EmoChat에서 얼굴 표정을 인식하는 방식을 통해 실시간으로 감정을 표현하고 서로 간의 감정이 더 잘 느껴지기 때문에 텍스트 기반 커뮤니케이션에서 나타나는 감정을 오해하는 등의 문제점을 해소할 수 있을 것이라 기대하였다. 그리고 EmoChat은 기존 메신저와 달리 대면 상황에서의 대화에 더 가까워진 메신저라고 평가하였으며, 정서적 유대감을 공유할 수 있을 것이라 답변했다.

“친구가 평소에 감정 표현을 잘 안 하는데, EmoChat에서는 감정을 정확하게 알 수 있었습니다. 감정의 교류나 공유가 잘 이루어졌다고 생각해요.” (P10)

EmoChat을 사용하는 데 상대방과의 관계가 영향을 미치는지에 대한 질문에서는 이미 가깝고 친밀한 관계에서는 영향을 미치지 않는다고 답변하였다. 반대로 새로운 관계의 사람들과 EmoChat을 통해 편하고 재미있게 대화를 나눌 것이라 하였고, 상대방을 파악하는 데 유용할 것이라 했다. 상대방이 어떤 말에 어떤 표정을 짓고 감정을 드러내는지 파악할 수 있기 때문이다. 또한, 친밀도가 낮은 상대방과 사용할 때 빠르게 친밀도를 높일 수 있고 감정 표현이 없는 상대방에게도 감정을 잘 느낄 수 있었다고 언급하였다. 이에 대해 P6는 기업의 단체 메신저처럼 어색한 관계의 사람들과 사용하면 활용도가 높을 것이라 했고, P21도 새로운 사람과 대화할 때 긍정적인 표현이 즉각적으로 느껴져서 어색한 분위기를 완화해 주는 데 유용하다고 답변했다.

1) 서체의 차별화와 감정의 다양화 필요

참가자들은 EmoChat의 개선점에 대해 서체의 차별화와 감정의 다양성을 언급하였다. 서체의 모양이나 특징이 유사하게 나타나는 것이 혼란스럽기 때문에 서체의 차별화와 대비가 뚜렷한 서체들이 필요하다고 하였다. 예를 들어 ‘궁금’이나 ‘정중함’, ‘기쁨’과 같은 감정을 언급하였으며, 서체와 감정이 더 다양해진다면 자신의 감정을 쉽고 상세하게 표현할 수 있을 것이라 기대하였다. 또한, 정서의 중복 선택을 통한 복합적인 감정의 표현으로 감정의 확장성에 대해 제시하였다.

2) 폭넓은 정서 단어 선택지 제공

사용자에게 감정별 5개의 정서 단어를 제공하여 감정을 세분화하였지만, 이에 대해서도 사용자는 선택의 폭이 좁다고 느껴 아쉬움을 표했다. 이는 참여자들이 기존 메신저에서 이모티콘과 같이 EmoChat에서는 서체에 자신의 감정을 반영하고 싶어 하는 것을 나타내기도 한다. 이에 EmoChat에서 어떤 감정을 많이 표현했는지에 대해 참여자들이 사용한 정서의 사용 빈도수는 총 1,907개로 확인되었다. 가장 많이 사용된 행복의 ‘재미’ 정서는 총 391회 사용됐고 이후 ‘다행’, ‘사랑’, ‘후련’, ‘긍지’ 순서로 나타났으며, 모두 100회 이상 선택되었다. 이외에 가장 많이 사용된 감정-정서는 놀람-놀라 149회, 슬픔-속상 110회, 분노-약오 28회, 혐오-환멸 13회로 나타났다. 감정의 사용률은 행복 53%, 놀람 25%로 메신저에서 주로 긍정적인 감정 표현을 위주로 한다는 인터뷰 응답과 유사한 결과로 나타났다.

5.4. 제언점

연구 결과를 통해 나타난 연구의 제언점 4가지는 다음과 같다.

첫째, 낮은 친밀도 관계를 중심으로 한 커뮤니케이션에 특화된 메신저를 개발하는 것이 제안된다. 모든 사용자와의 관계가 아닌 새로운 사람, 친밀도가 낮지만 친밀해지고 싶은 사용자 간의 사용에서는 긍정적인 평가를 받았기 때문에 EmoChat과 같은 감정 표현 메신저는 친밀함을 기대하는 관계에서 유용한 메신저로 나타났다. 반대로 위계적이거나 수직적인 관계에서의 사용에 대한 적합성은 상대적으로 낮게 평가되었으므로, 이러한 관계 유형에서의 효과적인 커뮤니케이션을 지원하는 방안을 모색해야 한다. 본 연구의 사용자 평가에 따르면 친밀하거나 편한 대화를 나눌 수 있는 가족, 친구와 같은 관계의 사람들과 사용할 것이라 평가하였으나, 새로운 사람과의 관계에서는 오히려 빠른 시간 내 친밀감을 형성하는 데 매우 유용할 것이라 평가하였다. 이는 다양한 관계 유형과 상황에서의 사용성에 대한 추가적인 탐색과 함께 메신저의 사용성과 범용성을 향상하기 위한 사용자 평가의 필요성을 시사한다.

둘째, 메신저 인터페이스에서의 다국어 확장 가능성이다. 본 연구에서는 한글 서체에 대해 느껴지는 감정과 감정요인, 정서에 초점을 맞췄으나 EmoChat의 인터페이스를 활용하여 다국어 서체로 확장한다면 다양한 문화적 배경과 언어적 특성을 고려한 사용자 중심 커뮤니케이션 도구로서 활용 및 확장이 가능할 것이다.

셋째, 얼굴 표정 인식 모델의 발전을 통한 메신저의 높은 사용성을 제공하는 것이다. 후속 연구에서는 얼굴 인식 모델의 발전을 통해 성능이 향상된다면, 보다 정확하고 실시간으로 사용자의 다양한 감정을 표현할 수 있는 메신저가 개발될 것이라 기대한다. 특히 모델의 사용자 표정 인식 시간과 인식률이 비례하게 되고, 빠른 시간에 명확하게 인식할 수 있는 모델의 성능이 중요하게 작용할 것이다. 이를 통해 사용자가 더 자연스럽고 풍부한 감정을 메신저에서 표현할 수 있게 된다면, 다양한 사용자 경험을 분석할 수 있을 것이다.

넷째, 모바일 환경으로도 구현하여 실제 메신저와 유사하게 접근성과 편의성을 높이는 것이다. 현재 대부분의 얼굴 표정 인식 모델은 PC 환경에서 빠르게 발전했지만, 모바일 환경에서는 여전히 인식 정확도와 속도가 떨어지는 것으로 나타나고 있다. 얼굴 인식 모델이 모바일 환경에서도 최적화된다면, 사용자는 기존 메신저와 유사하게 사용할 수 있을 것이다. 모바일 기기의 카메라를 통해 보다 정교한 표정 인식이 가능해지며, 이는 사용자에게 높은 접근성과 편의성을 제공할 것으로 기대한다. EmoChat의 모바일 환경 개발을 통한 사용성 개선은 메신저 커뮤니케이션의 새로운 발전 방향을 모색하는 데 기여할 것이다.

6. 결론

텍스트 기반 커뮤니케이션의 대표적인 서비스 메신저에서 상대방과 대면하고 대화를 나누는 대면 상황과 같이 감정 표현을 원활하게 하는 메신저 EmoChat을 제작하여 사용자 평가를 진행하였다. 본 연구에서는 메신저에서 감정 표현 향상을 위한 인터페이스를 서체를 통해 제안하고자 50개의 한글 서체를 선정하여 각 서체에서 어떤 감정과 감정 요인이 느껴지는지 설문조사를 통해 확인하였다. 이를 서체의 8 요인(행복, 놀람, 슬픔, 공포, 분노, 혐오, 긍·부정, 에너지) 다차원척도법 분석을 통해 서체와 정서 단어 30개 세트를 매칭시켰다.

감정과 서체, 정서와 서체의 매칭을 기반으로 프로토타입을 제작하였으며, 대면 상황에서의 대화와 같은 환경을 메신저에서 구현하고자 웹에 적합한 얼굴 표정 인식 AI 모델을 사용하였다. 사용자에게 감정을 더 세부적으로 선택하도록 제공하였으며, 이는 더 다양하게 자신의 감정을 표현할 수 있다는 점에서 긍정적인 평가를 받았다.

본 연구의 한계점은 다음과 같다.

첫째로는 서체 선정 과정에서 객관성 확보가 더 필요하다는 점이다. 본 연구에서 사용된 한글 서체는 무료 라이선스 내 사람들이 많이 사용하는 순위에 따라 총 188개를 선정하였으며, 동일한 분류 체계나 유사한 형태 요소를 가진 서체는 중복되어 제외하고 최종적으로 50개의 한글 서체를 선정하였다. 향후 연구에서는 서체 전문가의 평가를 포함하여 다중 검증을 진행함으로써 서체 선정 과정의 객관성을 확보할 필요성이 있음을 제안한다.

둘째로는 사용된 얼굴 인식 모델의 기능적인 한계이다. 웹에서 실시간으로 얼굴 표정을 인식하는 데 적합하고 가벼운 모델을 사용하여 빠르게 인식할 수 있었지만, 인식률과 인식 시간은 반비례하였다. 또한, 특정 감정의 낮은 표정 인식률이 존재하였다. 참여자들은 행복, 놀람, 슬픔에 비해 공포, 분노, 혐오와 같은 부정적인 감정은 얼굴 표정 인식이 훨씬 낮았다는 점을 언급하였다. 실험에서 취합된 감정의 사용률에서도 행복 53%, 놀람 25%, 슬픔 15%, 분노 3.6%, 혐오 2%, 공포 0.5%로 나타났으며, 특히 참여자들은 공포의 감정을 인식시키는 데 어려움이 있었다고 하였다. 이러한 기능적인 한계점들은 추후 얼굴 인식 모델의 성능 개선에 대한 사용자 경험 향상을 위한 중요한 고려 사항이 될 것이다. 또한, 모델의 기능적인 한계가 보완된다면 더 사용성이 높아질 것이라 기대하였다.

본 연구는 인간의 감정 표현에 기반한 메신저 인터페이스를 제안하여 기존의 텍스트 기반 커뮤니케이션에서 나타나는 한계점을 개선하고, 메신저에서의 새로운 사용자 경험을 제공한 것에 의의가 있다. 얼굴 표정의 즉시성을 활용하여 대면 상황에서의 대화에 가깝게 느끼도록 제작하였고, 서체와 정서 단어를 통해 사용자의 감정 표현을 다양화할 수 있는 메신저를 통해 사용자 간 커뮤니케이션을 향상시키고, 메신저 서비스를 다각화하는 데 도움이 될 것으로 기대한다.

Acknowledgments

This paper was written by reconstructing Suhyun Kim’s master’s thesis in 2024.

Notes

Copyright : This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0/), which permits unrestricted educational and non-commercial use, provided the original work is properly cited.

References

-

Amare, N., & Manning, A. (2012). Seeing typeface personality: Emotional responses to form as tone. 2012 IEEE International Professional Communication Conference, 1-9..

[https://doi.org/10.1109/ipcc.2012.6408605]

-

Choi, S., & Aizawa, K. (2019). Emotype: Expressing emotions by changing typeface in mobile messenger texting. Multimedia Tools and Applications, 78 , 14155-14172..

[https://doi.org/10.1007/s11042-018-6753-3]

-

Choi, S., Yamasaki, T., & Aizawa, K. (2016). Typeface emotion analysis for communication on mobile messengers. Proceedings of the 1st international workshop on multimedia alternate realities, 37-40..

[https://doi.org/10.1145/2983298.2983305]

-

De, A., & Saha, A. (2015). A comparative study on different approaches of real time human emotion recognition based on facial expression detection. 2015 International Conference on Advances in Computer Engineering and Applications, 483-487..

[https://doi.org/10.1109/icacea.2015.7164792]

-

Derks, D., Fischer, A. H., & Bos, A. E. (2008). The role of emotion in computer-mediated communication: A review. Computers in human behavior, 24 (3), 766-785..

[https://doi.org/10.1016/j.chb.2007.04.004]

-

Ekman, P. (1999). Basic emotions. In T. Dalgleish & M. J. Power (Eds.), Handbook of cognition and emotion (pp. 45-60). John Wiley & Sons Ltd..

[https://doi.org/10.1002/0470013494]

-

Ekman, P., Friesen, W. V., O'sullivan, M., Chan, A., Diacoyanni-Tarlatzis, I., Heider, K.,... & Tzavaras, A. (1987). Universals and cultural differences in the judgments of facial expressions of emotion. Journal of Personality and Social Psychology, 53(4), 712-717..

[https://doi.org/10.1037//0022-3514.53.4.712]

-

Ertay, E., Huang, H., Sarsenbayeva, Z., & Dingler, T. (2021). Challenges of emotion detection using facial expressions and emotion visualisation in remote communication. In Adjunct Proceedings of the 2021 ACM International Joint Conference on Pervasive and Ubiquitous Computing and Proceedings of the 2021 ACM International Symposium on Wearable Computers, 230-236..

[https://doi.org/10.1145/3460418.3479341]

-

Filipovic, F., Despotovic-Zrakic, M., Radenkovic, B., Jovanic, B., & Živojinovic, L. (2019). An application of artificial intelligence for detecting emotions in neuromarketing. In 2019 International Conference on Artificial Intelligence: Applications and Innovations (IC-AIAI) (pp. 49-494). IEEE..

[https://doi.org/10.1109/ic-aiai48757.2019.00016]

-

Hancock, J. T., Landrigan, C., & Silver, C. (2007). Expressing emotion in text-based communication. In Proceedings of the SIGCHI conference on Human factors in computing systems, 929-932..

[https://doi.org/10.1145/1240624.1240764]

-

Karbauskaite, R., Sakalauskas, L., & Dzemyda, G. (2020). Kriging Predictor for Facial Emotion Recognition Using Numerical Proximities of Human Emotions. Informatica, 31 (2), 249-275..

[https://doi.org/10.15388/20-infor419]

-

Kim, H., & Lim, S. (2017). 한글 글꼴 등록 시스템을 위한 글꼴 모양 분류체계 표준화 연구 [Standardization Study of Font Shape Classification for Hangul Font Registration System]. Journal of Korea Multimedia Society, 20(3), 571-580..

[https://doi.org/10.9717/kmms.2017.20.3.571]

- Kim, J., & Soh, Y. (2007). 온라인 인스턴트 메신저의 감정표현 방법 제안에 관한 연구 [A Study on Proposal of Emotional expression for Online instant Messenger]. Korean HCI Society Conference, 1128-1134..

- Kim, S. (2012). 이모티콘(Emoticon)의 표현 양상에 관한 연구 [A Study on the Expression Aspect in Emoticon]. Korean Semantics, 38, 1-25..

- Ko, Y., Sohn, E., & Lee, H. (2007). 커뮤니케이션 도구로써의 글꼴 및 휴대폰 문자 메시지에 대한 사용자 인식 [Users' perception on fonts as a tool of communication and SMS]. Archives of Design Research, 20(1), 133-142..

-

Kwak, M. (2021). 모바일 텍스트 메시지에 나타난 비언어적 커뮤니케이션 양상의 연구 [A Study on Aspects of Nonverbal Communication in Mobile Text Messages]. The Journal of Mirae English Language and Literature, 26(2), 57-86..

[https://doi.org/10.46449/MJELL.2021.05.26.2.57]

-

Lee, J., & Jun, S. (2017). 서체의 사용자 감정 반응 연구 [Measuring emotional responses to typefaces]. Korean HCI Society Conference, 62-65..

[https://doi.org/10.1080/24704067.2017.1283528]

-

Lee, J., Jun, S., Forlizzi, J., & Hudson, S. E. (2006). Using kinetic typography to convey emotion in text-based interpersonal communication. In Proceedings of the 6th conference on Designing Interactive systems, 41-49..

[https://doi.org/10.1145/1142405.1142414]

-

Lee, J., Kim, D., Wee, J., Jang, S., Ha, S., & Jun, S. (2014). 키네틱 타이포그래피를 통한 텍스트 기반커뮤니케이션에서의 감정 전달 연구 [Evaluating Pre-defined Kinetic Typography Effects to Convey Emotions]. Journal of Korea Multimedia Society, 17 (1), 77-93..

[https://doi.org/10.9717/kmms.2014.17.1.077]

- Lee, J., Song, H., Na, E., & Kim, H. (2008). 정서 단어 분류를 통한 정서의 구성 차원 및 위계적 범주에 관한 연구 [Classification of Emotion Terms in Korean]. Korean Journal of Journalism & Communication Studies, 52(1), 85-116..

- Lee, Y. (2021). 주제별 텍스트 일상 대화 데이터[Textual conversational data by topic]. AI Hub . www.aihub.or.kr/aihubdata/data/view.do?currMenu=115&topMenu=100&aihubDataSe=realm&d ataSetSn=543.

- Moon, M., & Chang, D. (2015). 서체 디자인 요소 변화에 따른 인상 연구 [The Research on Typeface Impression Depending on Change Of Design Factors]. Bulletin of Korean Society of Basic Design & Art, 16(4), 191-202..

- Parrott, W. G. (Ed.). (2001). Emotions in social psychology: Essential readings. psychology press..

-

Revina, I. M., & Emmanuel, W. S. (2021). A survey on human face expression recognition techniques. Journal of King Saud University-Computer and Information Sciences, 33(6), 619-628..

[https://doi.org/10.1016/j.jksuci.2018.09.002]

-

Russell, J. A. (1980). A circumplex model of affect. Journal of personality and social psychology, 39(6), 1161..

[https://doi.org/10.1037/h0077714]

-

Russell, J. A. (2003). Core affect and the psychological construction of emotion. Psychological Review, 110(1), 145-172..

[https://doi.org/10.1037//0033-295x.110.1.145]

-

Shan, C., Gong, S., & McOwan, P. W. (2009). Facial expression recognition based on local binary patterns: A comprehensive study. Image and Vision Computing, 27(6), 803-816..

[https://doi.org/10.1016/j.imavis.2008.08.005]

-

Shin, H., You, H., & Song, Y. (2023). AI에 적합한 일반 상식 추론 대화의 자동 생성을 위한 정량적, 정성적 연구 [CommonAI: Quantitative and Qualitative Analysis for Automatic-generation of Commonsense Reasoning Conversations Suitable for AI]. Journal of KIISE, 50 (5), 407-419. doi:10.5626/ JOK.2023.50.5.407.

[https://doi.org/10.5626/JOK.2023.50.5.407]

- Shin, Y., Hong, J., & Yang, J. (2005). 의미에 따른 선호 서체 개발에 관한 연구 [A study on the development of preferable font by meaning]. Korean Society for Emotion and Sensibility, 8(4), 375-384..

- Sohn, E. & Lee, H. (2008). 디지털 매체에서의 감성 표현을 위한 한글 글꼴 이미지 분류 연구 [study on image classification for HANGUL font for emotional expression on digital media]. KSDS Conference Proceeding, 164-165..

-

Son, O., & Nam, T. (2017). 디지털 텍스트 커뮤니케이션의 감성적 가치 증대를 위한 Telehandwriter 시스템 [Telehandwriter for Increasing Emotional Value of Digital Text Communication]. Korean HCI Society Conference, 563-566..

[https://doi.org/10.1145/3064857.3079185]

- Wiener, M., & Mehrabian, A. (1968). Language within language: Immediacy, a channel in verbal communication. Ardent Media..

- Youn, J. H., Seo, Y. H., & Oh, M. S. (2017). A Study on UI Design of Social Networking Service Messenger by Using Case Analysis Model. Journal of Information and Communication Convergence Engineering, 15(2), 104-111..

- Zhe, X., & Boucouvalas, A. C. (2002). Text-to-emotion engine for real time internet communication. In Proceedings of International Symposium on Communication Systems, Networks and DSPs, 164-168..