자율 방역 로봇 표정 감정 강도 요소 도출에 따른 최적 HRI(휴먼-로봇 인터랙션) 표정 디자인에 관한 연구

초록

연구배경 인간과 감정을 공유하는 로봇을 개발하기 위해서는 로봇이 다양한 상황에서 어떻게 적절한 감정을 표현할 수 있는지에 대한 연구가 필요하다. 전 세계적으로 감염병 예방을 위한 살균에 대한 관심이 높아지면서 검역 업무뿐만 아니라 인간과의 감정 교류까지 가능한 자율 검역 로봇 개발에 관심이 쏠리고 있다. 이에 본 연구는 인간과 자율 방역 로봇 사이의 최적 HRI 디자인을 위해서 로봇의 감정 강도를 구현할 수 있는 요소를 도출하고 이를 기반으로 한 자율 방역 로봇의 표정을 디자인 개발을 목적으로 한다.

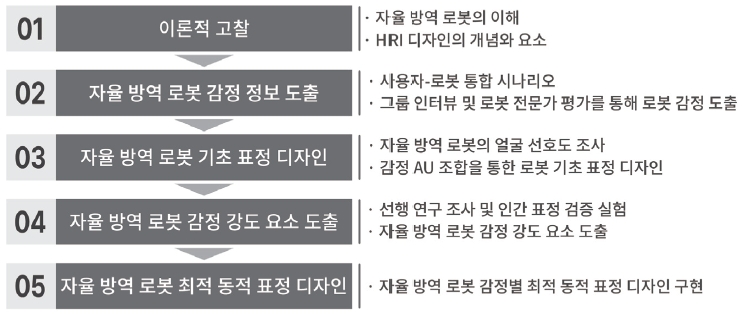

연구방법 이론적 고찰을 통해 자율 방역 로봇을 이해하고 HRI 디자인의 개념과 요소를 알아본다. 사용자-로봇 통합 시나리오를 작성하여 로봇의 상황에 따른 감정 정보를 도출하였다. 로봇 얼굴 선호도 조사를 통해 사용자가 가장 선호하는 로봇 얼굴을 선정하고 FACS 기반 AU 조합을 바탕으로 로봇의 기초 표정을 디자인하였다. 선행 연구 조사와 인간 표정 검증 실험을 통해 로봇 감정의 강도를 구현하기 위한 요소를 도출하고 인간 연기자의 표정 영상 분석으로 도출된 최적의 감정 강도 요솟값을 로봇 표정에 적용하였다.

연구결과 자율 방역 로봇의 7가지 감정에 대하여 인간 연기자의 표정 정보를 바탕으로 최적의 감정 강도 요솟값을 도출하고 그래프로 나타내었다. 그래프를 분석한 결과, 7가지 감정의 최적 강도를 가장 잘 표현할 수 있는 로봇 표정 구현 요솟값이 존재한다는 것을 알 수 있었다. 또한 속도, 지속시간, 눈깜박임, 색깔은 로봇의 감정 강도를 구현하기 위한 요소로 적절함을 검증하였다. 이는 각 감정을 효과적으로 표현할 수 있는 특정한 표정 구현 속성이 존재한다는 것을 나타내며 감정의 적절한 강도 구현을 통해 최적의 로봇 감정을 표현할 수 있는 로봇 표정을 디자인하였다.

결론 본 연구에서는 기존 로봇의 정형화된 감정 표현에 사용자와 로봇의 상황을 더하고 감정의 강도를 표현하기 위한 요소를 도출하였다. 이를 통해 로봇은 다양한 환경에서 효과적으로 로봇의 감정과 의도를 표현할 수 있으며 감정 강도를 조절하여 인간과 더욱 원활한 인터랙션이 가능하다. 또한 로봇 개발사와 로봇 전문가들이 유연하게 로봇 감정 시스템을 구현할 수 있도록 유용한 기초 자료를 제안하여 향후 완성도 높은 로봇을 개발할 수 있는 방향을 제시한 점에서 의의가 있다.

Abstract

Background To develop a robot that shares emotions with humans, it is necessary to study how robots can express appropriate emotions in various situations. As interest in sterilization to prevent infectious diseases increases worldwide, the development of autonomous quarantine robots that are capable of not only quarantine tasks but also emotional exchanges with humans is of interest. Therefore, this study describes the optimization of a human-robot interaction (HRI) design that facilitates the interaction between humans and autonomous quarantine robots by designing and developing the facial expressions of robots so that they can express emotions.

Methods We created a user-robot integration scenario to derive emotional information according to the situation of the robot. Then, we selected the facial expression of the robot preferred by the user through a survey and designed the robot's basic expression based on the Action Units (AU) combination. We derived elements to modulate the intensity of robot emotions based on previous research and human facial expression verification experiments. Finally, we applied the optimal emotional intensity factors derived from the analysis of videos showing the facial expressions of a human actor to the facial expressions of the robot.

Results We derived the optimal emotional intensity factors for producing the seven emotions of the autonomous quarantine robot and presented them in a graph. As a result, we found the values that can express the optimal intensity of the seven emotions. In addition, we verified that speed, duration, eye blinking, and color were appropriate for producing the desired emotional intensity by the robot. In addition, we developed a facial expression design that can express the optimal emotion of the robot through the appropriate emotional intensity.

Conclusions In this study, we add the situations of the user and the robot to the standardized emotional expression of the robot and derive elements to express the intensity of the emotion. Through this, the robot can effectively express its emotions and intentions in various environments and can interact smoothly with humans. In addition, we provide suggestions for developing optimized robots using basic data so that robot manufacturers and robot experts can implement an emotional system that adds flexibility to robot behavior.

Keywords:

Human-Robot Interaction (HRI), Emotional Intensity, Facial Expression Design, Autonomous Quarantine Robot, 감정 강도, 표정 디자인, 자율 방역 로봇1. 서론

1. 1. 연구의 배경과 목적

감정의 표현은 의사소통의 가장 근본이 되며, 상대방과 서로의 감정을 공유하면서 커뮤니케이션의 과정을 더욱 풍성하게 만들 수 있다. 오늘날 로봇 기술의 발전으로 다양한 기능을 수행하는 로봇이 우리의 일상생활 속에 들어와 많은 서비스를 수행하고 있으며, 로봇은 중요한 상호작용의 대상으로 주목받고 있다.

COVID 19와 같은 감염증 팬데믹으로 사람 사이의 접촉을 줄여주고 비대면으로 효율적인 업무가 가능한 로봇의 수요가 급격히 증가하고 있다. 특히 전염병이 강한 바이러스를 예방하기 위해서 자율 방역 로봇의 개발이 활발히 진행되고 있으나 인간과의 효율적인 인터랙션을 위한 감성적 능력이 부족한 실정이다. 자율 방역 로봇이 인간과 교류하는 과정에서 적절한 감정을 표현하고 감정 강도에 따른 최적의 표정을 구현할 수 있다면 더욱 효과적인 로봇 방역 서비스가 가능해질 것이다.

따라서 본 연구는 최적 휴먼-로봇 인터랙션(HRI: Human-Robot Interaction)을 위해 자율 방역 로봇의 적절한 감정 강도에 따른 표정 디자인 개발을 목적으로 한다.

1. 2. 연구의 범위와 방법

최근 COVID 19 팬데믹으로 비대면 서비스에 최적화된 전문 서비스 로봇들이 많이 개발되고 있으며, 장기간 진행 중인 전염병에 대응하기 위하여 다양한 분야에 적용·확산 중이다.

본 연구에서는 자율주행과 원격제어로 비대면 서비스가 가능하고 국내외 로봇 시장에서 상용화 사례가 증가하고 있는 자율 방역 로봇을 연구 대상 사례로 선정하였다.

현재 로봇의 감성 시스템을 구축하고 감정에 따라 표정을 구현하기 위한 연구가 활발히 이루어지고 있다. 인간의 반응에 대해 로봇도 그에 상응하는 감정 표현 및 표정의 구현이 가능해야 인간과 효과적인 커뮤니케이션이 가능하다. 따라서 감성 능력을 갖춘 로봇 디자인 개발을 위해서 HRI 디자인의 요소 중 표정에 초점을 맞추어 연구를 진행하였다.

연구의 방법은 다음과 같다. 첫 번째, 이론적 고찰을 통해 자율 방역 로봇을 이해하고 HRI 디자인의 개념과 요소를 알아보았다. 두 번째, 자율 방역 로봇의 감정 정보를 도출하기 위한 사용자-로봇 통합 시나리오를 작성한 후, 세부적인 로봇 상황 분류에 대하여 그룹 인터뷰와 로봇 전문가의 평가를 통해 자율 방역 로봇의 최적 감정 정보를 도출하였다. 세 번째, 선호도 조사를 통해 자율 방역 로봇의 얼굴을 선정한 뒤, FACS 기반 감정 AU 조합을 도출하여 자율 방역 로봇의 감정을 표현하는 기초 표정을 디자인하였다. 마지막으로 선행 연구의 조사와 인간 표정 검증 실험을 통해 자율 방역 로봇의 감정 강도를 표현할 수 있는 요소를 도출하였다. 자율 방역 로봇의 7가지 감정을 표현하는 인간의 표정 정보를 수집하여 인지도 평가를 수행하고 각 감정에 대한 최적의 감정 강도 구현 요솟값을 알아내고, 감정별 자율 방역 로봇의 최적 동적 표정 디자인을 구현하였다.

2. 이론적 고찰

2. 1. 자율 방역 로봇의 이해

전염성이 강한 COVID 19 바이러스의 발병에 따라, 전 세계적으로 바이러스의 확산을 방지하고 예방하기 위한 방역 및 살균에 관심이 높아지고 있는 상황이다. 이에 따라 사람 사이의 접촉을 줄여주고 비대면으로 효율적인 업무가 가능한 로봇의 수요가 급격히 증가하고 있으며, 특히 많은 기업과 단체에서 로봇을 활용한 방역 인프라를 구축하고 있다.

중소벤처기업부(MSS, 2022)의 중소기업 전략기술로드맵에 따르면, 자율 방역 로봇은 자율주행 및 지능형 센서 등을 장착하고 살균·방역 능력을 갖추어 전염병의 확산을 예방하거나 시설물 등에 있는 바이러스 및 유해 세균 등을 살균하는 로봇이다. 자율 방역 로봇은 자율주행 기술이 적용되어 자유롭게 공간 이동이 가능하며 주어진 환경을 스스로 인식하고 방역 기능을 수행할 수 있다.

자율 방역 로봇의 개발 현황 분석을 통해 기술적으로 자율주행, 자동 충전 시스템, UVC 소독·살균 등 최첨단 기술의 구현이 가능함을 알 수 있다. 하지만 자율 방역 로봇의 서비스 대상이 되는 사용자와 상호작용을 위한 인터랙션 요소가 부족한 상황이다. 소리를 통해서 알림이나 단순한 정보만을 제공할 뿐 자율 방역 로봇이 사용자에게 친근하고 자연스럽게 인식되기 위한 감성 인터랙션이 적용되지 않은 사례가 대부분이다.

따라서 자율 방역 로봇과 사용자 간의 원활한 피드백 교환이 가능하게 하고 로봇의 세부적인 감정적 반응을 구현한다면 인간에게 보다 편리한 방역 서비스를 제공할 수 있을 것이다.

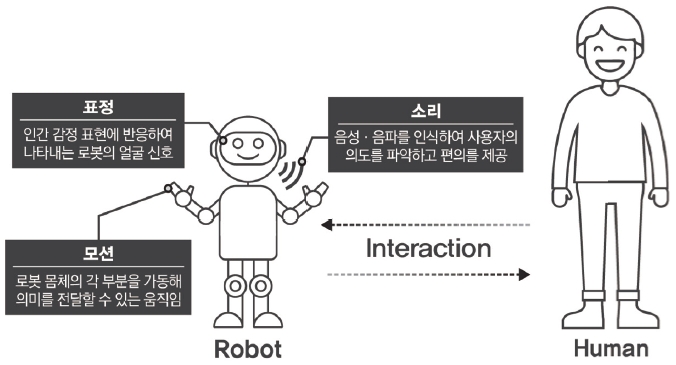

2. 2. HRI 디자인 개념과 요소

오늘날 로봇은 다양한 맥락에서 인간과 긴밀한 관계를 맺고 있으므로 상대방의 의도를 이해하고 서로 긍정적인 영향을 미치기 위해서는 HRI 디자인의 연구가 중요하다. 홍성수(Hong, 2022)에 따르면, HRI 디자인은 인간이 로봇에게 명령하거나 로봇으로부터 인간이 정보를 전달받는 과정을 의미하며, 사용자가 원하는 기능을 수행하도록 인터랙션을 제공하는 개념이다. 또한 홍성수는 HRI 디자인의 요소가 모션, 표정, 소리로 구성되어 있다고 주장하였다. HRI 디자인 요소의 정의는 Figure 2에 나타난 것과 같다. 로봇의 감성 시스템을 구축하고 감정에 따라 표정을 구현하기 위한 연구가 활발히 이루어지고 있다. 인간의 반응에 대해 로봇도 그에 상응하는 감정 표현 및 표정의 구현이 가능해야 인간과 효과적으로 인터랙션이 가능하다.

3. 로봇 인터랙션을 위한 감정 정보 도출

3. 1. 사용자-로봇 통합 시나리오

사용자와 로봇의 관점에서 시간의 흐름에 따른 방역 서비스 과정의 시나리오를 작성하여 사용자와 로봇이 느끼는 감정을 도출하고자 하였다.

사용자-로봇 통합 시나리오 도출은 로봇이 인간과 대면하여 ‘인사’라는 ‘기능’을 적절히 수행하기 위해 ‘반가운’ 감정과 ‘슬픈’ 감정 중 어떤 감정을 표현하는 것이 적절한지 알아내고자 그에 해당하는 상황을 제시하는 것에 목적이 있다. 다만, 사용자의 표정을 자극원으로 인식한 후 대응 감정을 구현하는 복합적 인터랙션 상황을 나타내기에는 본 연구에서 도출한 시나리오의 구체성이 부족할 수 있다. 향후 로봇이 사용자 표정을 인풋 정보로서 인식할 수 있는 인간-로봇의 표정 대 표정 인터랙션 연구를 더욱 면밀히 진행하고자 한다.

자율 방역 로봇은 주로 공공장소나 병원 등의 장소에서 사용되며 사람의 밀집도나 전염의 위험 수준을 고려했을 때 자율 방역 로봇이 더욱 잘 활용될 수 있는 회사를 사용 환경으로 설정하였다. 사용자는 회사에서 보내는 시간이 많은 30대의 남성 회사원으로 설정하고 자율 방역 로봇과의 인터랙션 상황을 통합 시나리오로 나타내고자 하였다.

3. 2. 자율 방역 로봇의 감정 정보 도출

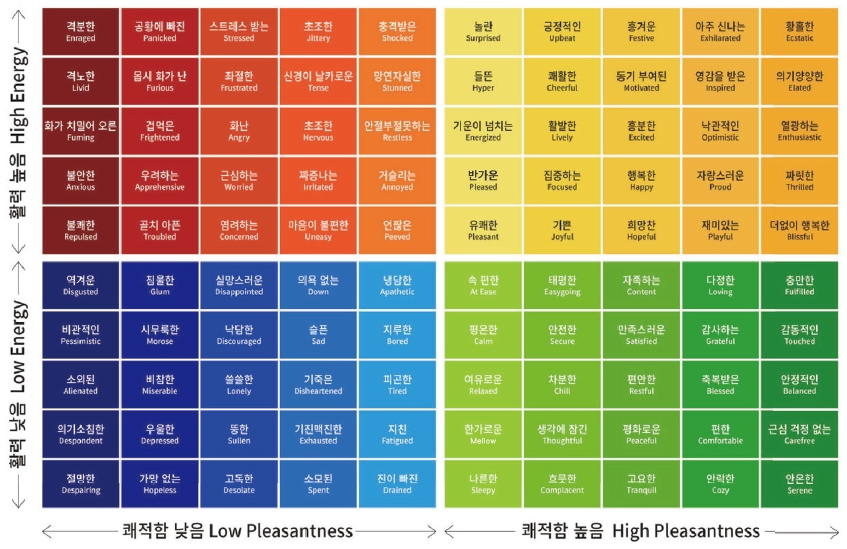

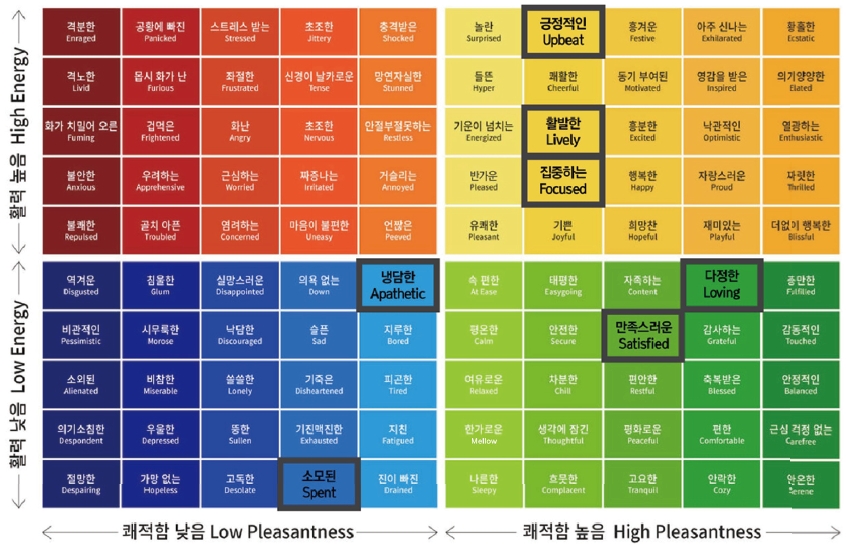

사용자-로봇 통합 시나리오를 통해서 도출된 로봇의 세부적인 상황을 방역 단계에 따라 분류하여 정리하였다. 로봇 상황에 적절한 감정 정보를 수집하기 위해는 무드미터를 사용하여 그룹 인터뷰를 진행하였다. 무드미터는 마크 브래킷이 저술한 『감정의 발견』에 등장하는 개념으로 감정을 인식하고 측정하기 위해 만들어진 도구이다. 무드미터의 감정들은 ‘쾌적함’과 ‘활력’의 정도에 따라 4개의 부분으로 나뉘며, 각 단계별로 감정의 강도가 달라지는 것을 나타낸다.

다만, 한 가지 주목해야 할 점은 각 나라의 고유한 언어 차이로 인해 영문의 감정 형용사를 한국어로 번역하는 과정이 완벽하지는 않다는 점이다. Figure 3을 보면 오른쪽 상단 부분의 ‘Pleased’와 오른쪽 하단 부분의 ‘Satisfied’가 ‘만족스러운’이라는 같은 감정 형용사로 번역되는 것을 발견할 수 있다. ‘Pleased’가 위치한 영역을 고려해보면 쾌적함과 활력이 높으므로 ‘반가운’을 적용하는 것이 적절해 보인다. 따라서 감정 형용사의 인지 오류를 줄이기 위해 ‘Pleased’는 ‘반가운’으로 ‘Satisfied’는 ‘만족스러운’으로 적용하였다.

그룹 인터뷰는 평균 나이 22.5세의 일반인 남녀 18명(남 10, 여 8)으로 구성된 참가자들과 진행했으며, 각 9명씩 2개의 A, B그룹으로 나누어 인터뷰를 진행하였다. 우선 참가자들에게 사용자-로봇 통합 시나리오를 설명한 후 무드미터의 개념과 역할을 소개하였다. 이어서 사용자-로봇 통합 시나리오를 바탕으로 로봇 상황에 가장 적합한 감정을 무드미터에서 도출하도록 요청하였다. 그 결과, 참가자들에 의해 도출된 자율 방역 로봇의 상황별 감정 정보는 Table 3과 같다.

A그룹과 B그룹에서 각 로봇 상황에 따른 감정 정보를 도출하게 한 뒤, 중복된 감정을 순위별로 나타내었다. 각 감정 정보 밑에 명시되어 있는 괄호 속 숫자는 로봇의 상황에 적합한 감정이라고 선택한 피실험자의 수이다. A그룹과 B그룹의 감정 정보 도출 결과를 2순위까지 통합하여 최종 감정을 도출하였다.

3. 3. 자율 방역 로봇의 감정 정보 검증

무드미터를 통해서 도출된 감정 정보가 자율 방역 로봇의 상황을 올바르게 표현하는지 검증하기 위한 평가를 진행하였다. 로봇 전문가(남자 5명, 여자 3명) 8인과 함께 각 로봇의 상황별로 도출된 감정 정보 중 어떤 감정이 로봇의 의도를 더욱 잘 표현할 수 있는지에 대해 5점 척도로 점수를 부여하는 평가를 진행하였다. 그 결과 평균 점수 4.0점 이상으로 높은 점수를 받아 최종 도출된 자율 방역 로봇의 감정 정보는 [긍정적인], [냉담한], [다정한], [만족스러운], [소모된], [집중하는], [활발한] 이다.

4. 로봇 기초 표정 디자인

4. 1. 로봇 얼굴 선호도 조사

로봇은 인터랙션을 할 때 사용자의 특성에 맞는 최적의 표정을 구현할 수 있어야 한다. 인간과 달리 로봇의 얼굴은 3D, 2D, 프로젝트형 등 다양한 방식으로 표현될 수 있으나, 본 연구에서는 2D로 표현되는 디지털 얼굴로 로봇 표정을 구현하고자 하였다.

정혜승, 조은경, 그리고 홍성수(Jeong, Jo, and Hong, 2021)가 진행한 선행 연구에 따르면, 만 20~59세의 나이를 가지는 성인은 간단한 표정 정보를 표현할 수 있는 수준의 추상적인 눈과 입의 요소를 가지는 얼굴 디자인을 선호한다는 것을 알았다. 따라서 자율 방역 로봇의 얼굴 유형을 Figure 4와 같이 홍채와 동공이 표현되지 않고 속눈썹, 치크(Cheek)와 같은 상세한 얼굴 요소가 없이 추상적인 눈과 입의 요소만을 가지는 얼굴로 설정하였다.

사용자들이 가장 선호하는 자율 방역 로봇의 얼굴을 알아보기 위해서 로봇 얼굴 디자인의 선호도 평가를 수행하였다. 실험은 만 20세에서 59세의 일반인 30명(남자 19명, 여자 11명)을 대상으로 진행되었다. 제공하는 설문지에 보이는 자율 방역 로봇의 얼굴 디자인 6가지 타입 이미지를 피실험자가 확인한 뒤, 가장 선호도가 높은 로봇 얼굴 디자인에 관해서 7점 척도로 평가하는 방식으로 평가가 진행되었다. 피실험자의 이해를 높이기 위해 긍정과 부정의 2가지 표정을 디자인하였다.

4. 2. 자율 방역 로봇 얼굴 선호도 분석

자율 방역 로봇의 적합한 얼굴을 알아보기 위해 선호도 검증 평가를 수행한 결과, 타입 2의 로봇 얼굴이 선호도 점수 5.9점으로 가장 높은 점수를 받았다. 성인은 다른 5가지 로봇 얼굴 디자인보다 두꺼운 윤곽선으로 이루어진 직사각형의 눈과 추상적인 입을 가진 로봇 얼굴이 자율 방역 로봇에 가장 적합한 얼굴이라고 평가하였다.

4. 3. 자율 방역 로봇 감정의 AU 조합 도출

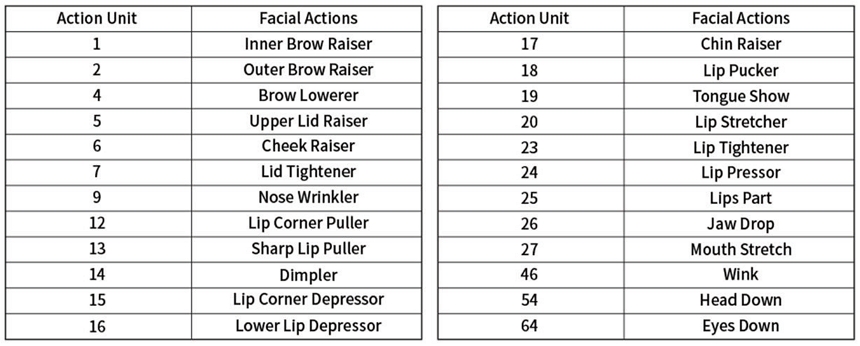

자율 방역 로봇의 7가지 감정 정보를 로봇 표정으로 표현하기 위해서 FACS(Facial Action Coding System)를 활용하였다. 최동운, 이덕연, 그리고 이동욱(Choi, Lee, and Lee, 2020)에 따르면, FACS는 심리학자 에크만과 프리젠이 3천 개 이상의 표정을 연구하여 인간의 감정에 의해 나타나는 얼굴의 움직임을 해부학 기반으로 분석한 시스템이다. 인간의 감정을 나타내는 표정은 AU(Action Unit) 조합으로 만들어지며, AU는 얼굴 근육의 부위와 움직임의 세기를 나타내는 알파벳으로 표기된다.

자율 방역 로봇의 7가지 감정을 키워드로 하여 인터넷 검색 및 문헌 조사를 수행하고 성인의 인간 남성 얼굴이 표현하는 표정 이미지를 수집하였다. 수집된 성인 인간의 표정 이미지를 비교·분석하여 공통된 얼굴 움직임을 도출한 후, 각 감정의 표정을 Table 7과 같이 AU 조합으로 나타내었다.

4. 4. 자율 방역 로봇 기초 표정 디자인 도출

도출된 인간 표정의 AU 조합을 기반으로 자율 방역 로봇이 표현할 수 있는 7가지 감정의 기초 표정을 디자인하였다. 감정을 표현하는 기초 표정의 단계는 5단계로 구성하였으며 1단계의 기본 표정에서 2~4단계의 표정 변화를 거친 뒤, 다시 5단계의 기본 표정으로 돌아온다. 자율 방역 로봇의 기초 표정을 기반으로 5장에서는 감정 강도 구현을 위한 요소를 도출하고 자율 방역 로봇의 감정별 최적 동적 표정을 디자인하고자 한다.

5. 자율 방역 로봇 감정 강도 구현

5. 1. 선행 연구 조사 및 분석

로봇의 표정 디자인 구현을 위한 요소를 도출하기 위해서 22건의 선행 연구를 분석하였다. 그 결과, 로봇 표정의 다양한 강도 구현으로 인한 효과성을 알아보기 위한 연구가 6건(27.2%)으로 나타났으나 표정을 구현하기 위한 특정한 요소가 정립되어 있지 않고 로봇 표정의 강도를 강, 중, 하로 분류할 뿐이었다. 그 외에 로봇의 감정을 표정으로 표현할 때의 표정 구현 속도에 관한 연구가 9건(40.9%)으로 가장 많았으며, 로봇의 눈깜박임에 관한 연구가 4건(18.1%), 로봇 얼굴의 색깔에 관한 연구가 3건(13.6%)으로 분석되었다.

선행 연구를 살펴보면 로봇의 표정 구현 속도에 관한 연구가 가장 큰 비중을 차지하고 있으므로 ‘속도’는 로봇의 감정 강도를 구현하기 위한 요소로 충분해 보인다. 선행 연구자 샹소, 로한, 그리고 아일렛(Chanseau, Lohan, and Aylett, 2015)은 속도가 표정 이해와 감정 이해에 영향을 미친다는 것을 보여주기 위해 로봇의 표정 구현 속도를 달리하는 연구를 진행했으며, 6가지 기본 감정(슬픔, 분노, 기쁨, 놀람, 혐오, 공포)을 표현하는 표정에 대해서 3가지 속도(40m/s, 50m/s, 60m/s)를 제시하여 다양한 감정들이 서로 다른 속도로 제시되어야 함을 주장하였다. 이렇듯 로봇의 ‘기쁜’ 표정과 ‘화난’ 표정을 가장 잘 표현할 수 있는 특정한 표정 구현 속도를 적용함으로써 적절한 로봇 표정 디자인을 구현할 수 있다. 그러므로 로봇의 감정 강도를 표현하기 위한 요소로 「속도」는 적절하다는 것을 도출하였다.

또한 요시카와, 시노자와, 이시구로, 하기타, 그리고 미야모토(Yoshikawa, Shinozawa, Ishiguro, Hagita, and Miyamoto, 2006)는 눈을 깜박이는 빈도에 따라 상대방에게 다른 인상을 줄 수 있다고 주장하면서 로봇과 현실적이고 효과적인 의사소통을 위해 눈을 깜박이는 행동이 중요한 요소가 될 수 있다고 말했다. 다채로운 로봇의 표정 디자인을 구현하기 위해서 「눈깜박임」의 요소는 적절해 보인다.

김민규, 이희승, 박정우, 조수훈, 그리고 정명진(Kim, Lee, Park, Jo, and Chung, 2008)은 로봇의 감정 강도를 표현하기 위해 색과 깜박임에 대해 연구하여 결과적으로 슬픔, 혐오, 화남의 경우 색깔과 깜박임을 통해 감정 강도를 높일 수 있었다고 말했다.

5. 2. 로봇 감정 강도 구현 요소 도출

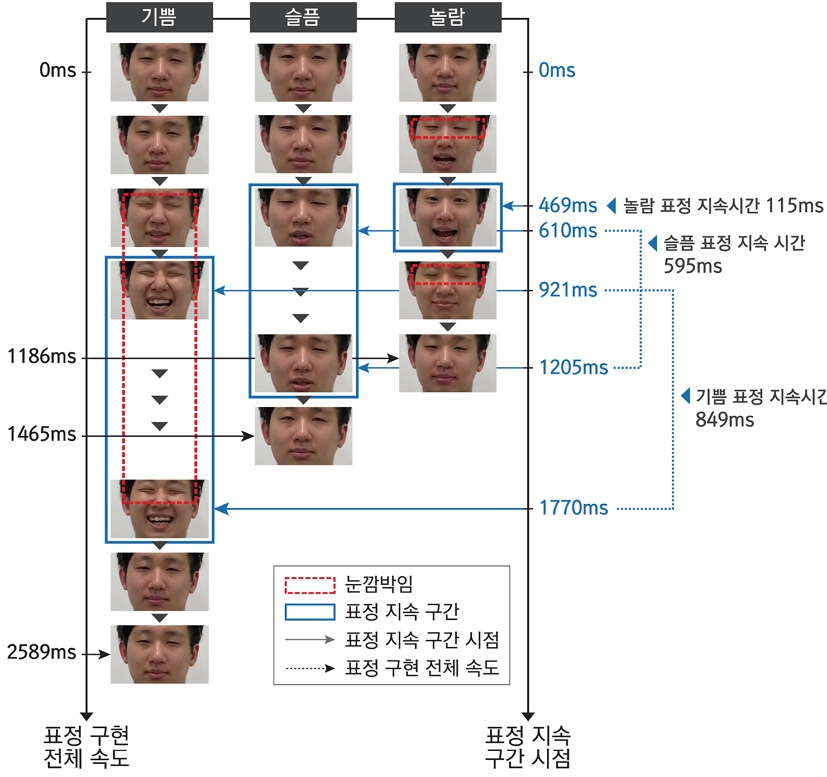

로봇 감정 강도의 구현을 위한 요소 도출에 앞서 감정에 따른 인간의 표정 표현을 바탕으로 선행 연구에서 분석한 표정 구현 요소가 알맞은지 검증해보고 더 요구되는 요소는 없는지 알아보고자 하였다. 먼저, 인간 연기자(남, 26살)에게 ‘기쁨’, ‘슬픔’, ‘놀람’의 감정을 느낄 수 있도록 3가지의 자극 영상을 보여준 뒤 각 감정을 표정으로 표현하게 하고 영상으로 녹화하였다. 녹화된 영상을 분석하여 3가지 감정을 표현한 인간의 표정을 정리한 결과는 Figure 6과 같이 나타내 보았다.

감정에 따른 인간의 표정을 분석한 결과 3가지 감정의 표정 구현 속도가 모두 달랐다, ‘기쁨’ 감정의 경우, 감정 정점에 도달하기까지의 표정 구현 속도는 921ms이며, 표정 구현의 전체 속도가 2589ms로 감정 중에 속도가 가장 느렸다. 반면, ‘놀람’ 감정의 경우, 감정 정점에 도달하기 위한 표정 구현 속도가 469ms이고, 표정 구현의 전체 속도가 1186ms로 가장 빨랐다. 또한 감정의 정점을 유지하는 표정의 지속시간이 달랐음을 알 수 있으며, ‘슬픔’과 ‘놀람’보다 ‘기쁨’ 표정의 지속시간이 849ms로 가장 오래 유지된다는 것을 발견하였다. 눈깜박임이 나타나는 감정은 ‘기쁨’으로 1회 눈을 깜박이고, ‘놀람’ 감정은 2회 깜박여 눈을 깜박이는 횟수와 시점이 다름을 알 수 있다.

선행 연구의 분석을 통해 이미 도출된 「속도」와 「눈깜박임」의 요소는 로봇의 감정 강도 구현 요소에 해당한다는 것을 확인하였다. 인간 표정 검증의 실험을 통해 표정 「지속시간」이 로봇 감정 강도의 구현 요소로 적절함을 알 수 있었다.

색깔 요소에 관해서 인간의 표정을 분석했을 때, 3가지 감정에 대한 인간 얼굴의 색깔 표현은 실험 결과로 활용하기에 부족하였다. 하지만, 인간이 분노의 감정을 느끼면 혈류의 변화를 통해 얼굴색이 붉어진다는 야마다와 와타나베(Yamada, and Watanabe, 2007)의 주장과 색을 통해 슬픔, 혐오, 화남의 감정 강도를 극대화할 수 있다는 김민규, 이희승, 박정우, 조수훈, 그리고 정명진(Kim, Lee, Park, Jo, and Chung, 2008)의 선행 연구 분석 결과를 바탕으로 「색깔」은 감정을 더욱 강조할 수 있는 요소로 충분하다. 또한 긴장하거나 겁에 질렸을 때 얼굴색이 창백해진다거나, 열이 나거나 부끄러울 때 얼굴색이 빨갛게 달아오르는 개인적인 경험을 통해서 얼굴 색깔이 감정을 극대화한다고 주장할 수 있다. 따라서 본 연구에서는 색깔을 로봇 표정 디자인에 적용할 수 있는 감정 강도 구현 요소로 설정하였다.

로봇 얼굴의 색깔은 앞서 언급한 무드미터를 사용하여 적용하였다. 로봇의 감정 정보를 무드미터에서 추출하였으므로 무드미터에 이미 지정되어 있는 각 감정의 색깔을 로봇의 얼굴에 표현하고자 하였다.

따라서 이를 종합해보면 로봇의 감정 강도를 구현할 수 있는 요소는 「속도」, 「지속시간」, 「눈깜박임」, 「색깔」로 도출되었으며, 각 요소의 정의는 Table 9와 같다.

5. 3. 자율 방역 로봇의 감정 기반 표정 정보 수집

평균 나이 22.5세의 일반인 연기자 6명(남 3, 여 3)을 모집하여 자율 방역 로봇의 최적 감정 강도 구현 요솟값을 도출하기 위한 실험을 진행하였다. 6명의 연기자에게 7가지의 감정을 나타내는 대표 인간 표정 이미지를 보여준 뒤, 이미지와 유사하게 표정을 짓도록 요청하고 영상으로 녹화하였다. Table 10은 해당 감정을 표현하는 대표 인간의 표정과 연기자들 6명의 표정을 이미지로 정리하여 나타낸 것이다.

5. 4. 최적 표정 인지도 평가

6명의 연기자가 표현한 7가지의 감정의 표정 정보가 얼마나 해당 감정을 잘 반영하는지 알아보기 위해 인지도 평가를 수행하였다. 평균 나이 23세의 일반인 12명(남 8, 여 4)에게 각 연기자의 표정 영상을 보여주고 제공되는 설문지에 가장 표정 정보를 잘 표현하는 연기자를 선정하도록 요청하였다. 인지도 평가 결과는 Table 11에 나타나 있으며, 7가지 감정에 대하여 피실험자가 선정한 연기자의 번호를 표시하여 나타내었다.

카이제곱 검정을 통해서 연기자(6명)의 감정(긍정적인, 냉담한, 다정한, 만족스러운, 소모된, 집중하는, 활발한) 간에 유의한 차이가 있는지 파악해 보았다. p-value 값이 0.00933으로서 각 연기자들의 감정 간에 유의한 차이(p-value=0.05 기준)가 있다는 결론을 낼 수 있었다.

5. 5. 자율 방역 로봇의 감정 강도 요소 검증

로봇의 최적 표정 디자인을 도출하기 위해 6명의 연기자를 모집하여 표정 정보를 수집하였고 선호도 평가를 통해 6개의 표정 표본 중 사용자들이 가장 선호하는 감정별 최적 표정을 선정하였다. 선정된 표정 데이터는 방역 로봇의 최적 표정 디자인을 구현할 수 있는 요솟값을 확인 및 검증하는 데 활용되었다.

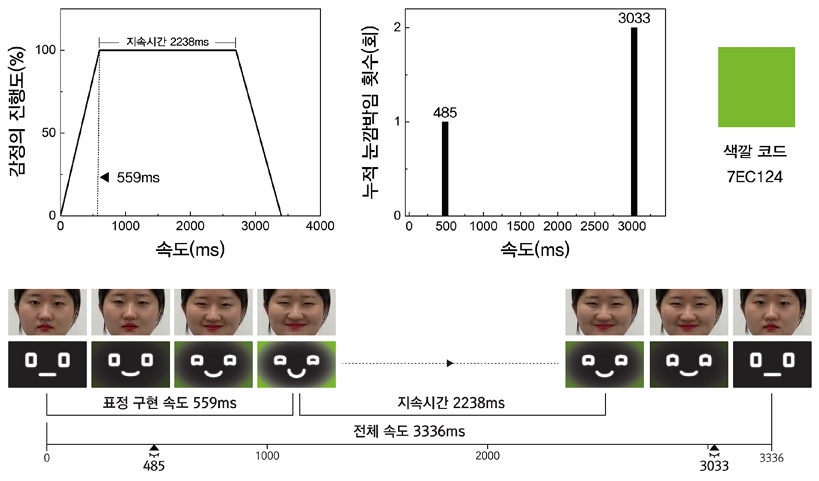

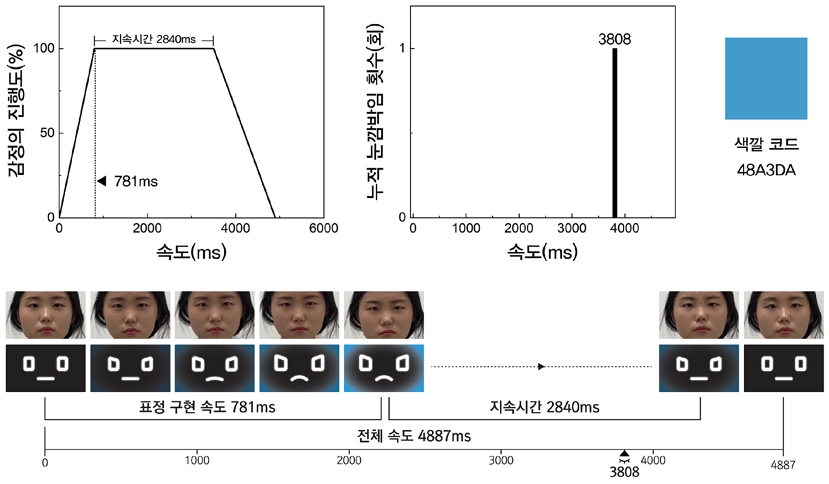

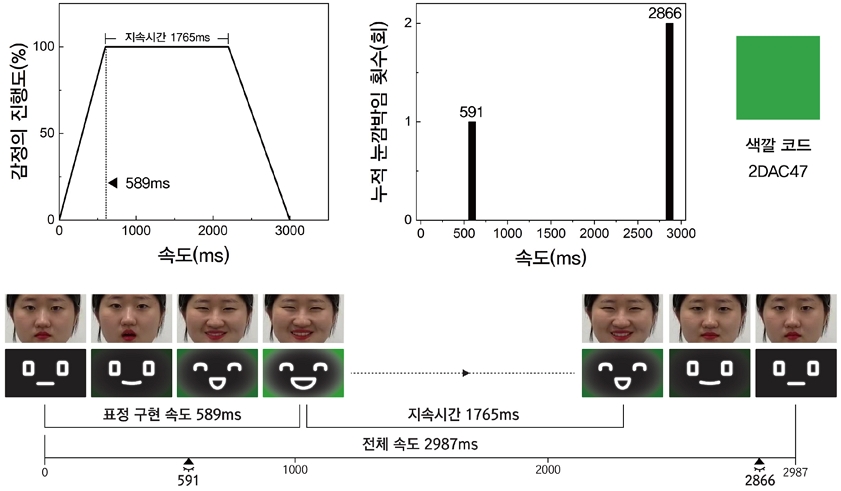

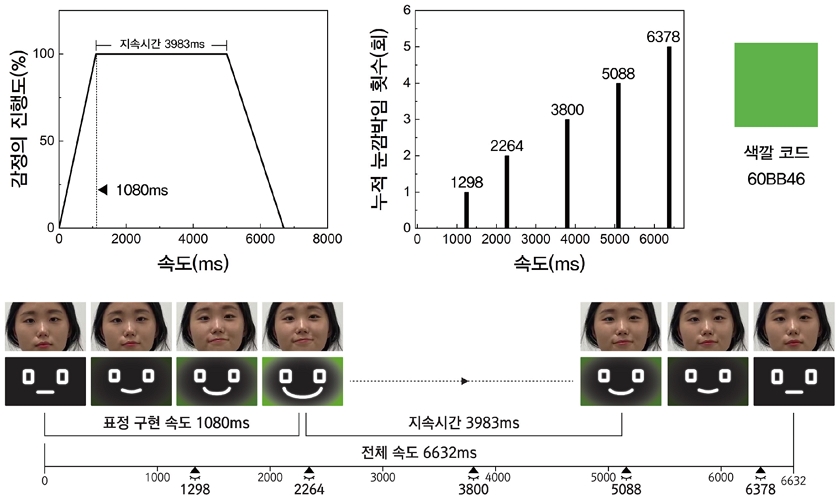

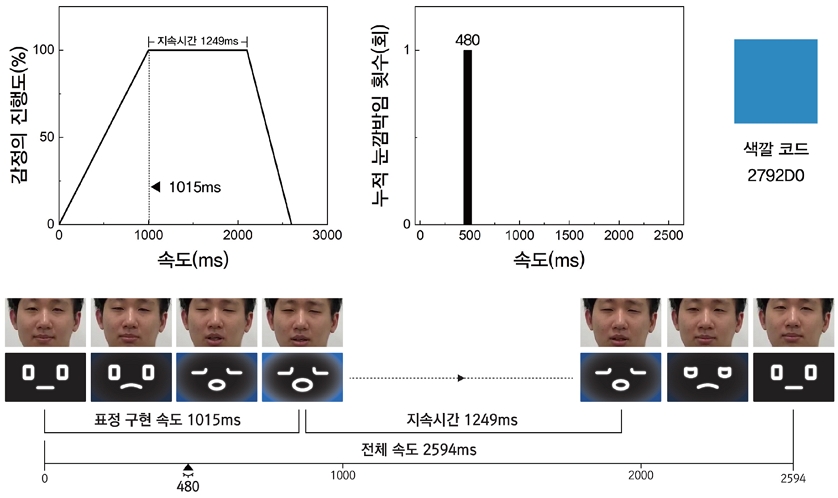

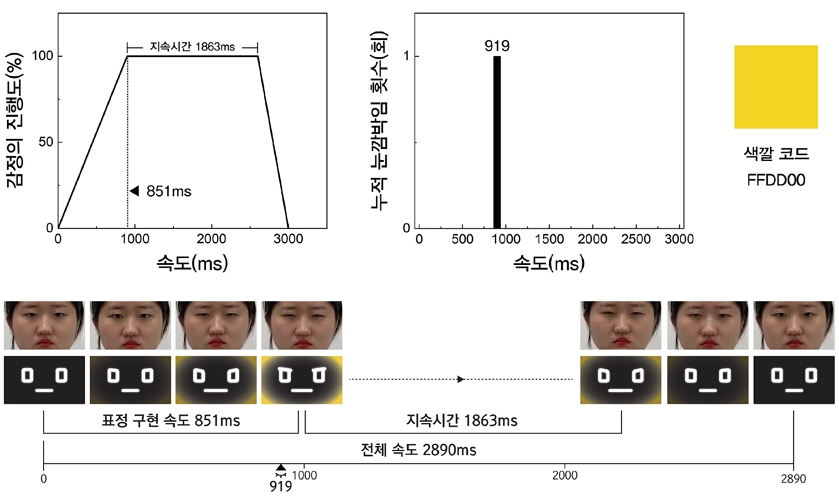

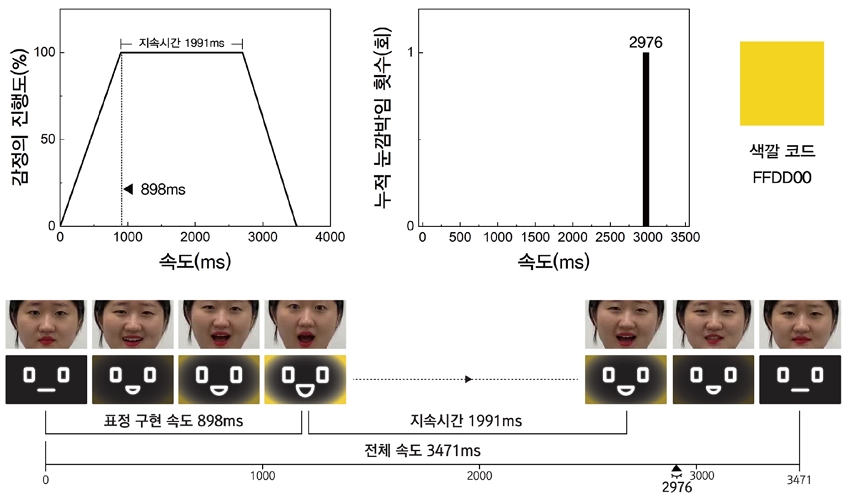

선정된 연기자의 표정 영상을 저속 재생하여 분석한 결과, 자율 방역 로봇의 7가지 감정에 대한 표정 강도 구현 요솟값을 도출할 수 있었다. 자율 방역 로봇의 감정 고도화를 위해 도출한 감정 강도 요소를 검증하기 위해 각 감정의 강도 구현 요솟값을 속도, 지속시간, 눈깜박임의 그래프로 표현했으며, 무드미터의 색깔 코드를 명시하여 로봇 얼굴에 적용할 수 있는 색깔을 나타냈다. 또한 앞서 인지도 평가에서 가장 높은 점수를 받아 선정된 연기자의 표정과 해당 감정의 로봇 표정을 매칭하여 나타내었다.

‘긍정적인’ 감정의 표정 구현 속도는 559ms이며 감정의 진행이 정점에 이르렀을 때 표정이 유지되는 지속시간은 2238ms이다. 눈깜박임은 표정 구현의 전체 속도인 3336ms 중, 485ms와 3033ms 시점에 2회 표현된다. 무드미터에서 추출한 얼굴 색깔 코드는 [7EC124]로, 연두색에 가까운 색깔을 표현해 긍정적인 에너지를 전달한다.

‘냉담한’ 감정의 표정 구현 속도는 781ms이며 감정의 진행이 정점에 이르렀을 때 표정이 유지되는 지속시간은 2840ms이다. 눈깜박임은 표정 구현의 전체 속도인 4887ms 중, 3808ms 시점에 1회 표현된다. 무드미터에서 추출한 얼굴 색깔 코드는 [48A3DA]로, 차갑고 냉랭한 느낌을 준다.

‘다정한’ 감정의 표정 구현 속도는 589ms이며 감정의 진행이 정점에 이르렀을 때 표정이 유지되는 지속시간은 1765ms이다. 눈깜박임은 표정 구현의 전체 속도인 2987ms 중, 591ms와 2866ms 시점에 2회 표현된다. 무드미터에서 추출한 얼굴 색깔 코드는 [2DAC47]로, 의사소통하는 상대방의 감정을 안정시켜주고 따뜻한 이미지를 전달한다.

‘만족스러운’ 감정의 표정 구현 속도는 1080ms이며 감정의 진행이 정점에 이르렀을 때 표정이 유지되는 지속시간은 3983ms이다. 눈깜박임은 표정 구현의 전체 속도인 6632ms 중, 1298ms, 2264ms, 3800ms, 5088ms, 6378ms 시점에 5회 표현된다. 무드미터에서 추출한 얼굴 색깔 코드는 [60BB46]으로, 여유롭고 기분이 좋은 느낌을 제공한다.

‘소모된’ 감정의 표정 구현 속도는 1015ms이며 감정의 진행이 정점에 이르렀을 때 표정이 유지되는 지속시간은 1249ms이다. 눈깜박임은 표정 구현의 전체 속도인 2594ms 중, 480ms 시점에 1회 표현된다. 무드미터에서 추출한 얼굴 색깔 코드는 [2792D0]으로, 불안정하고 감정적으로 약한 느낌을 더욱 강조한다.

‘집중하는’ 감정의 표정 구현 속도는 851ms이며 감정의 진행이 정점에 이르렀을 때 표정이 유지되는 지속시간은 1863ms이다. 눈깜박임은 표정 구현의 전체 속도인 2890ms 중, 919ms 시점에 1회 표현된다. 무드미터에서 추출한 얼굴 색깔 코드는 [FFDD00]으로, 정신력을 강화하여 집중력을 높이는 느낌을 제공한다.

5. 6. 자율 방역 로봇의 감정 강도 요소 분석

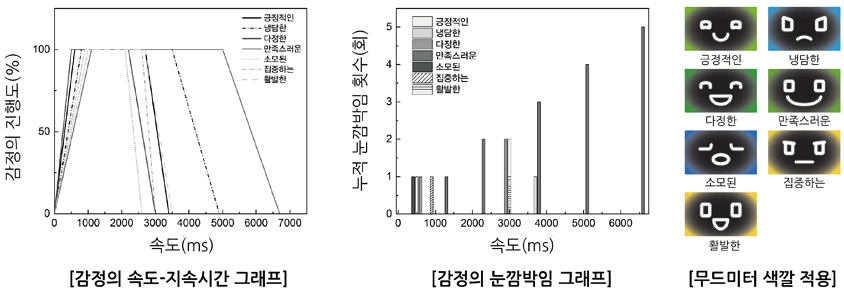

자율 방역 로봇의 7가지 감정(긍정적인, 냉담한, 다정한, 만족스러운, 소모된, 집중하는, 활발한)을 통합하여 그래프로 나타낸 것은 Figure 15와 같다.

그래프를 분석한 결과, 7가지 감정의 최적 강도를 구현하는 요솟값이 모두 차이를 가지며 이는 해당 감정을 가장 잘 표현할 수 있는 표정의 동적 특성이 존재한다는 것을 보여준다. 가장 효율적으로 감정을 표현할 수 있는 특정한 표정 구현 속성을 바탕으로 로봇과 인간의 더욱 밀접한 인터랙션이 가능하다.

특히 감정의 속도와 지속시간의 통합 그래프를 분석해 보았을 때, 7가지 감정 중에 다소 부정적인 감정에 속하는 ‘소모된’ 감정의 표정 지속시간이 가장 짧았으며, 표정의 전체 구현 속도도 가장 빨랐다. 반면 ‘만족스러운’ 감정의 경우 표정의 지속시간이 가장 길었으며, 표정의 전체 구현 속도도 가장 느렸다. 이는 ‘소모된’ 감정을 표현하는 로봇의 상황을 고려해보았을 때, 로봇이 작동하기 위한 에너지가 부족함을 나타내는 것이므로 빠르고 긴박하게 ‘소모된’ 감정을 나타내는 것이 적절하다는 것을 보여준다. 또한 ‘만족스러운’ 감정을 나타내는 로봇의 상황은 인간과의 인터랙션이 원활하게 수행되었거나 서비스의 결과 스스로 뿌듯한 상황을 나타내므로 로봇이 여유롭고 느긋하게 ‘만족스러운’ 감정을 표현하는 것이 적절하다.

이와 같은 상황을 잘 보여주듯이 ‘소모된’ 감정과 ‘만족스러운’ 감정의 눈깜박임 시점과 횟수를 비교해보면 ‘소모된’ 감정은 표정이 구현되는 초기 시점에 1회 눈을 깜박이지만, ‘만족스러운’ 감정의 경우 표정이 구현되는 동안 일정한 간격으로 총 5회 눈을 깜박인다. 눈깜박임의 시점과 횟수에 따라서 부정적인 감정은 더 급박하고 부정적으로, 긍정적인 감정은 더 여유롭고 편안하게 감정 강도를 조절할 수 있다.

또한 무드미터에서 추출한 각 감정의 색깔 코드를 자율 방역 로봇의 얼굴에 적용하여 색깔을 적용하지 않았을 때보다 감정을 분명하게 전달할 수 있으며, 로봇의 감정을 더욱 강조할 수 있다.

앞서 도출된 속도, 지속시간, 눈깜박임, 색깔은 로봇의 감정 강도를 구현할 수 있는 요소로 적절하다는 것을 증명할 수 있었다. 이와 같이 최적의 감정 강도로 로봇 표정을 구현할 수 있다면 더욱 정확하고 올바른 로봇의 감정 표현이 가능할 것이며 감정 강도 요솟값을 조절하여 감정 표현 수준을 더욱 높일 수 있다.

최적 감정 강도가 구현된 ‘활발한’ 표정을 짓고 있는 자율 방역 로봇의 적용 사례 이미지는 Figure 16과 같다.

6. 결론 및 향후 연구 과제

본 연구에서는 자율 방역 로봇의 표정에 초점을 맞추어 감정 강도를 구현할 수 있는 요소를 도출하고 자율 방역 로봇의 표정을 디자인하였다.

자율 방역 로봇의 이해와 HRI의 개념 및 요소를 알아보는 이론적 고찰을 수행한 후, 자율 방역 로봇의 방역 상황을 분석하는 사용자-로봇 통합 시나리오를 작성하였다. 그룹 인터뷰를 통해 도출한 자율 방역 로봇의 상황별 감정들을 로봇 전문가들과 함께 평가 및 검증하였고 최종적으로 자율 방역 로봇의 7가지 감정(긍정적인, 냉담한, 다정한, 만족스러운, 소모된, 집중하는, 활발한)이 확정되었다.

또한 자율 방역 로봇의 얼굴 선호도 조사를 통해서 만 20~59세의 사용자는 두꺼운 윤곽선으로 이루어진 직사각형 눈과 추상적인 입을 가진 로봇 얼굴 디자인을 선호한다는 것을 알았다. 7가지 감정을 나타내는 인간의 표정 이미지를 수집하여 FACS 기반 AU 조합을 도출하였고 자율 방역 로봇의 감정을 표현하는 기초 표정 5단계를 디자인하였다. 선행 연구 분석 및 인간 표정 검증 실험을 통해서 로봇의 감정 강도를 구현하기 위한 요소를 도출하였으며, 7가지 감정을 표현하는 연기자의 표정 정보를 바탕으로 자율 방역 로봇의 최적 감정 강도 요솟값을 도출하였다. 이를 통해 속도, 지속시간, 눈깜박임, 색깔은 로봇의 감정을 고도화하기 위한 요소로 적절함을 검증하였고 각 감정을 가장 잘 표현할 수 있는 특정한 표정 구현 속성이 존재한다는 것을 알았다.

본 연구에서는 로봇이 인간과의 감성적인 커뮤니케이션 상황에서 표현할 수 있는 최적 감정 정보에 따라 감정 강도 표현이 가능한 요소를 도출하고 로봇 표정 디자인을 수행했다. 본 연구는 감정 고도화 요소 도출을 통해 로봇 표정 강도를 구성하는 고도화 요소를 그래프(수치화·시각화)를 통해 정량적으로 제시하였다는 것에 연구 의의가 있다. 또한 로봇이 감정 강도 요소 4가지(속도, 지속시간, 눈깜박임, 색깔)를 적절히 조절 · 조합하여 다양한 표정을 구현할 수 있는 감정 강도를 효과적으로 표현하고 인간과 더욱 친밀한 인터랙션을 할 수 있도록 발판을 마련했다.

전 세계적으로 로봇의 수요가 높아짐에 따라 다양한 로봇을 개발하는 로봇 개발사들은 본 연구를 로봇 감정 시스템 구현의 유용한 기초 자료로 활용할 수 있을 것이며 향후 로봇 감정 표준 모형을 구축할 수 있는 방향을 제시하였다. 또한 로봇 엔지니어와 로봇 디자이너 등 로봇 전문가들은 감정 강도를 구현할 수 있는 요소를 조절하여 유연하게 로봇의 감정과 표정을 디자인할 수 있다.

다만, 모든 로봇의 상황 시나리오를 바탕으로 감정 정보를 도출하고 로봇 표정을 구현하기 위해서는 많은 양의 감정 및 표정 디자인 데이터가 필요하다. 향후 본 연구의 결과를 바탕으로 다양한 로봇의 감정과 표정 정보 빅데이터를 수집하고 각 데이터베이스를 로봇 감정 시스템에 적용할 수 있다면 인간과 같이 복잡한 감정을 구현할 수 있는 완성도 높은 로봇을 개발할 수 있을 것으로 보인다.

Acknowledgments

이 연구는 산업통상자원부 산업기술혁신사업의 지원으로 진행되었음 (Project No. 20009760).

This research was supported by Industrial Technology Innovation Project funded by the Ministry of Trade, Industry and Energy - Republic of Korea (Project No. 20009760).

Notes

Copyright : This is an Open Access article distributed under the terms of the Creative Commons Attribution Non-Commercial License (http://creativecommons.org/licenses/by-nc/3.0/), which permits unrestricted educational and non-commercial use, provided the original work is properly cited.

References

-

Adeline, C., Katrin, S. L., & Ruth, A. (2015). How motor speed of a robot face can influence the "older" user's perception of facial expression?. 2015 24th IEEE International Symposium on Robot and Human Interactive Communication (RO-MAN), 468-473.

[https://doi.org/10.1109/ROMAN.2015.7333596]

- Choi, D., Lee, D., & Lee, D. (2020). 감정표현을 위한 FACS 기반의 안드로이드 헤드의 개발 [Development of FACS-based Android Head for Emotional Expressions]. JOURNAL OF BROADCAST ENGINEERING, 25(4), 537-544.

- Hong, S. (2022). 로봇 디자인 실무 [Robot design practice]. Unpublished book.

- Jeong, H., Jo, E., & Hong, S. (2021). 서비스 로봇 얼굴 디자인을 위한 연령별 선호도 기초 연구 [Basic research on age-specific preference for service robot face design]. KSDS Conference Proceeding, 314-315.

- Kim, M., Lee, H., Park, J., Jo, S., & Chung, M. (2008). 로봇 감정의 강도를 표현하기 위한 LED의 색과 깜빡임 제어 [Color and Blinking Control to Support Facial Expression of Robot for Emotional Intensity]. 한국HCI학회 학술대회[The HCI Society of Korea], 547-552.

- Marc, B. (2020). 감정의 발견 [Permission to Feel]. Seoul: Booklife.

- Ministry of SMEs and Startups. (2022). 중소기업 전략기술로드맵 2022-2024 [SME Strategic Technology Roadmap 2022-2024]. 92.

- Park, H. (2021). 서비스 로봇 시장 및 기술 동향 [Service Robot Market and Technology Trends]. GT Insight, 1.

-

Takashi, Y.. & Tomio, W. (2007). Virtual Facial Image Synthesis with Facial Color Enhancement and Expression under Emotional Change of Anger, RO-MAN 2007 - The 16th IEEE International Symposium on Robot and Human Interactive Communication, 49-54,.

[https://doi.org/10.1109/ROMAN.2007.4415052]

-

Yuichiro, Y., Kazuhiko, S., Hiroshi, I., Norihiro, H., & Takanori, M. (2006). The effects of responsive eye movement and blinking behavior in a communication robot. 2006 IEEE/RSJ International Conference on Intelligent Robots and Systems, 4564-4569.

[https://doi.org/10.1109/IROS.2006.282160]